OpenAI在6月13日于官网宣布对其大型语言模型 API(包括 GPT-4 和 gpt-3.5-turbo)进行重大更新,包括新增函数调用功能、降低使用成本、以及为 gpt-3.5-turbo 模型提供 16000 个 token 的版本。OpenAI的更新主要包括以下六个方面的内容:

- 在Chat Completions API新增函数调用(Function call)功能

- 改进了gpt-4和gpt-3.5-turbo版本

- 更新了gpt-3.5-turbo的16k上下文版本

- 嵌入式模型降低了75%的成本

- gpt-3.5-turbo的输入tokens成本减少了25%

- 宣布了gpt-3.5-turbo-0301和 gpt-4-0314模型的弃用时间表

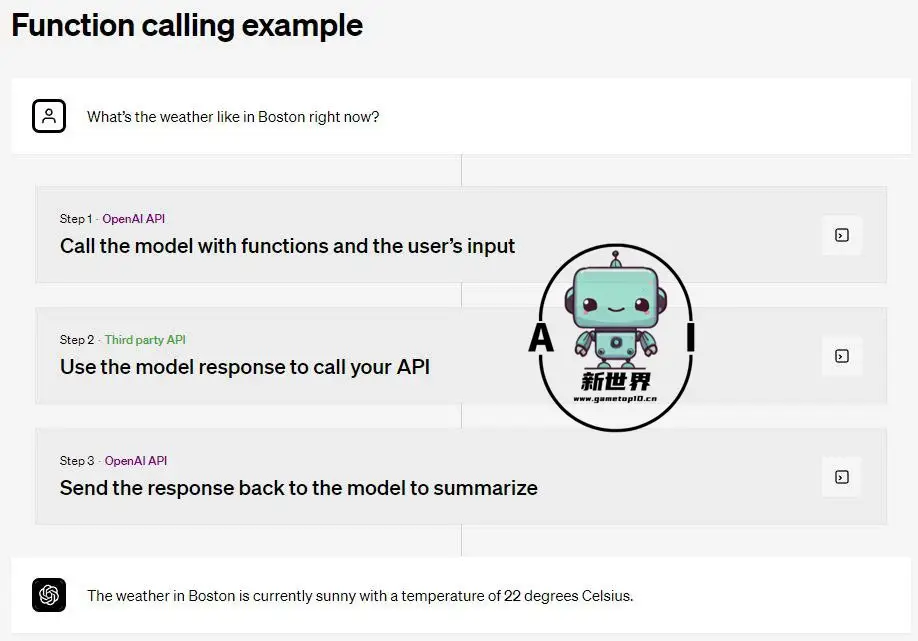

OpenAI在博客文章中称,目前新增的函数调用功能允许开发人员向GPT描述编程函数,并让模型选择输出一个包含参数的JSON对象来调用这些函数。函数调用功能可以让开发者更容易地构建能够调用外部工具、将自然语言转换为外部 API 调用或进行数据库查询的聊天机器人。例如,它可以将“给 Anya 发邮件,看看她下周五是否想喝咖啡”这样的输入转换为“send_email (to: string, body: string)”这样的函数调用。尤其是,这个功能还可以让 API 用户更容易地生成 JSON 格式的输出,这是之前很难实现的。

除了函数调用功能之外,OpenAI 还发布了gpt-3.5-turbo-16k模型。此前,由于使用者输入的文字内容过长,生成式AI模型往往会“忘记”一部分人机对话窗口的内容,从而导致生成的内容偏离主题,而gpt-3.5-turbo解决了该问题。

据悉,新版gpt-3.5-turbo支持16000 tokens的上下文长度,比目前的gpt-3.5-turbo要长4倍,而且使用者仅需高于普通gpt-3.5-turbo两倍的价格。简单来讲,使用者输入1000个tokens需要支付0.003美元,模型生成1000个tokens,使用者需要支付0.004美元。

从OpenAI的介绍来看,20页的文本的长度就等于16000 tokens的上下文长度,那100页文本的长度也就是80000 tokens的上下文长度。而处理一次文本需要经历输入-输出完整的过程,也就是说处理1000 tokens整体就是0.007美元,计算下来100页文本需要0.56美元(折合人民币约为4元)。

原文地址:https://openai.com/blog/function-calling-and-other-api-updates