文章目录[隐藏]

[t-success icon='']AI·快讯[/t-success]

1、传谷歌Gemini接近发布,已开启小范围内测

据外媒The Information报道,知情人士透露,谷歌已向一部分公司提供了其对话式AI产品Gemini的早期版本,这可能意味着谷歌即将把它纳入其消费者服务,并通过公司的云计算部门出售给企业。一位测试过Gemini的人士表示,与GPT-4相比,Gemini有一个优势在于,除了公共信息外,该模型还利用了来自其消费产品的大量谷歌专有数据进行训练。他表示,这使得Gemini在理解用户特定查询的意图时特别准确,而且它似乎会产生更少的错误答案(即幻觉)。另一位人士表示,谷歌计划通过其谷歌云Vertex AI服务向企业提供Gemini,并将发布不同大小的版本,以便开发人员可以付费购买不太复杂的版本来处理简单的任务或一项复杂的任务。它足够小,可以在个人设备上运行。该人士补充说,谷歌目前正在向开发人员提供相对较大的Gemini版本,但不是其正在开发的最大版本,后者将更接近GPT-4。

2、谷歌 CEO:从容推进 AI 发展战略,现阶段重心为夯实基础

谷歌首席执行官孙达尔・皮柴(Sundar Pichai)近日表示,会更加从容地推进公司 AI 发展战略,并不急于将 AI 整合到现有产品中。皮柴坦言 ChatGPT 的到来,表明公众越来越愿意与人工智能接触。

采访内容如下:

这是一个令人兴奋的时刻,我们现阶段的重心放在构建基础技术上,然后再考虑部署到我们的产品中,但我们现在仍在考虑发展方向。我们的技术弧相对比较长,但我非常满意公司当前的发展。

你让蝙蝠说话。我们每年都在人工智能方面进行创新,并将人工智能应用于搜索。竞争总是存在的,但我们应该更加注重长远发展,这才是最重要的。

3、智源发布中英文语义向量模型训练数据集MTP

据智源研究院微信公众号发文,9月14日,在北京人工智能产业峰会暨中关村科学城科创大赛颁奖典礼现场,智源研究院发布面向中英文语义向量模型训练的大规模文本对数据集MTP(Massive Text Pairs)。据介绍,这是目前最大的中、英文文本对训练数据集,数据规模达3亿对,其中中文1亿、英文2亿,这也是智源此前发布的开源中英文语义向量大模型BGE训练所用的数据集。

4、可口可乐合作小度构建AIGC创作工具

据可口可乐中国官网14日发文,可口可乐与智能科技品牌小度达成合作,打造了具有“未来3000年视觉”的专属模型。消费者可进入“可口可乐吧”小程序,上传照片得到“未来3000年”后的画面,利用小度灵机大模型的多模态识别技术用户可通过对话方式对画面进行修改。

5、a16z发布全球访问量Top 50 AI产品榜单

当地时间9月13日,风投公司a16z(Andreessen Horowitz)发布了截至2023年6月的全球访问量最高50个AI产品榜单,数据来源于Sensor Tower和SametimeWeb 。数据显示,ChatGPT的流量占这50个产品每月流量总和的60%,其每月访问量约为16亿次,每月用户数约2亿,这使得ChatGPT成为全球访问量排名第24的网站。

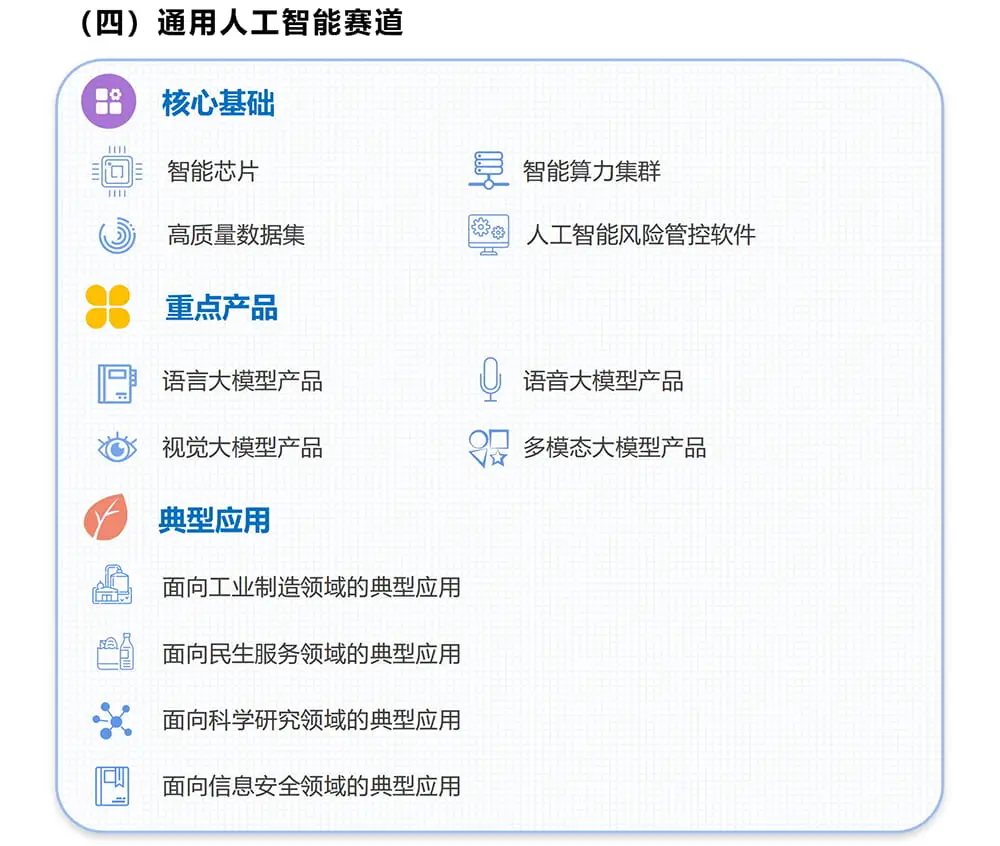

6、工信部启动AGI等4大未来产业揭榜挂帅

9月13日,工信部印发关于组织开展2023年未来产业创新任务揭榜挂帅工作的通知,面向元宇宙、人形机器人、脑机接口、通用人工智能4个重点方向提出工作要求。其中,面向通用人工智能提出智能芯片、智能算力集群、高质量数据集、人工智能风险管控软件4个核心基础,聚焦语言、语音、视觉、多模态大模型产品,加速面向工业制造、民生服务、科学研究信息安全领域的典型应用。提出到2025年,训练芯片支持FP16、FP32和混合精度(FP16/FP32)处理能力,智能算力集群节点扩展规模不低于1024卡,实现通用文本数据集规模总量达到10TB、通用图文数据集数据总量达到1亿对、通用音视频数据集数据总量达到100TB等预期目标。

7、微软AI-writing功能开启内测

据Windows Latest报道,微软近日邀请少量用户在Edge浏览器上测试AI-writing功能,此功能由GPT-4和Bing AI提供支持,可帮助用户撰写博文、新闻报道和电子邮件等。

8、以色列AI创企Deci发布两款高效率开源大模型

据VentureBeat报道,以色列AI创企Deci于当地时间13日发布了两个开源基础模型,分别是图像到文本生成器DeciDiffusion1.0和文本到文本生成器DeciLM 6B,并推出了一个名为Infery LLM的软件开发工具(SDK)。据介绍,Deci专注于实现生成式AI推理的效率和速度提升,DeciDiffusion比直接竞争对手模型Stable Diffusion 1.5快三倍,而DeciLM 6B比Meta的Llama 2 7B快15倍。

DeciDiffusion1.0 Demo地址:https://huggingface.co/spaces/Deci/DeciDiffusion-v1-0

DeciLM 6B Demo地址:https://huggingface.co/spaces/Deci/DeciLM-6b-instruct

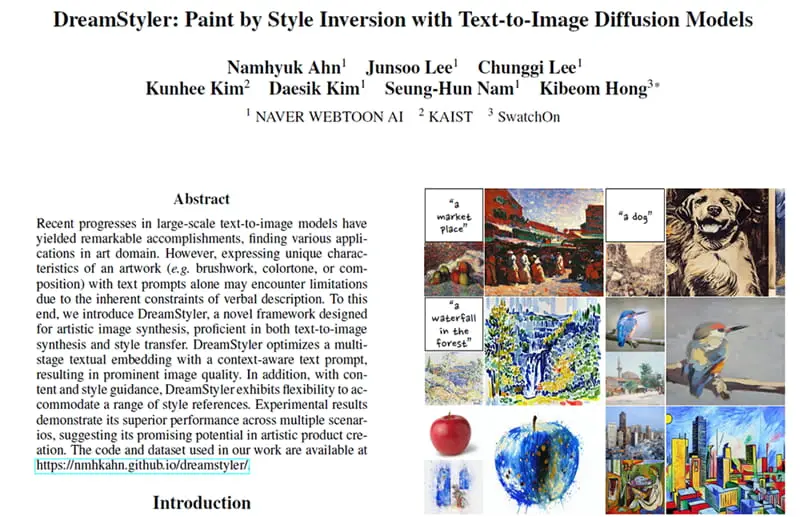

9、NAVER等发布风格绘画模型DreamStyler

9月13日,韩国互联网巨头NAVER旗下NAVER WEBTOON AI等单位研究人员发布了风格绘画大模型DreamStyler,可通过文字或图像生成风格迁移的结果。

10、智源等挑战10万美元预算开发千亿参数大模型

据量子位报道,智源研究院、科学院等机构和高校的联合团队成功挑战用10万美元预算从头训练一个全新的千亿参数大模型FLM-101B,该模型于上周开源发布。据悉,GPT-3的训练成本约为460万美元,而FLM只用了2.17%的成本,就达到了接近的效果和性能。据论文介绍,在Open LLM数据集上测试显示,该模型在ARC、HellaSwag、MMLU和TruthfulQA四个项目中取得的平均成绩接近GLM-120B和Llama-7B,其中TruthfulQA的单项成绩超过Llama 2;在专业知识上,16B参数的eFLM在C-eval评测中,平均成绩超过了130B参数的GLM,并接近ChatGPT。

论文地址:https://arxiv.org/abs/2309.03852

Hugging Face开源地址:https://huggingface.co/CofeAI/FLM-101B