文章目录[隐藏]

大语言模型(LLMs)在过去几年中取得了令人瞩目的进展,展示了强大的自然语言处理能力。然而,这些模型的快速增长也带来了显著的资源消耗和可扩展性挑战。LLMs通常需要大量的GPU基础设施和电力,导致高昂的部署和维护成本。这不仅限制了小企业和个人用户的访问,还增加了碳足迹,引发了可持续性问题。

为了解决这些问题,微软最近开源了bitnet.cpp,这是一个高效的1位大语言模型推理框架,可以直接在CPU上运行。

bitnet.cpp 的特点

1. 高效推理

- CPU友好:bitnet.cpp允许在标准CPU上运行大型语言模型,包括拥有1000亿参数的模型,而无需GPU。

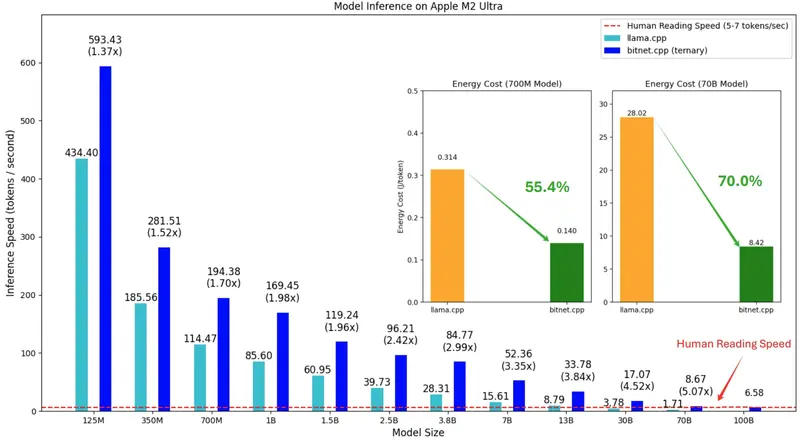

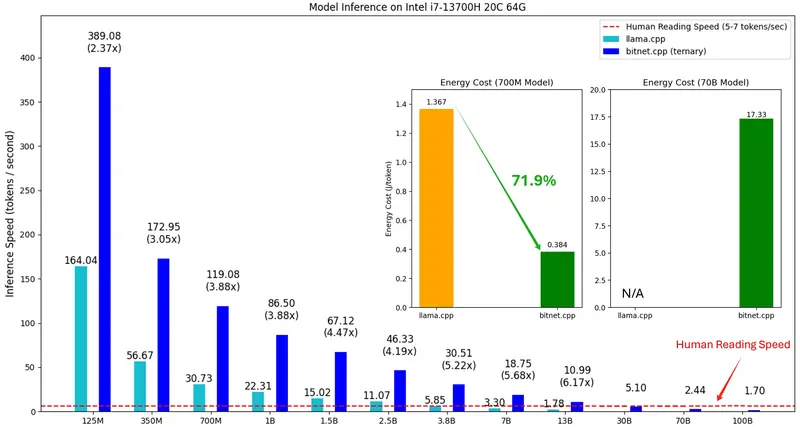

- 显著加速:在ARM CPU上实现了1.37倍到5.07倍的加速,在x86 CPU上实现了2.37倍到6.17倍的加速。

- 能源效率:能源消耗减少了55.4%到82.2%,使得推理过程更加节能。

2. 广泛支持

- 硬件支持:当前支持ARM和x86 CPU,并计划在未来增加对NPU、GPU和移动设备的支持。

- 模型兼容性:支持包括BitNet b1.58在内的1位LLMs。

3. 性能优化

- 定制内核:bitnet.cpp包括一组针对CPU推理优化的内核,最大化模型性能。

- 接近人类阅读速度:能够在单个CPU上以接近人类阅读速度(约每秒5-7个token)运行复杂模型。

bitnet.cpp 的影响

1. 民主化LLMs

- 降低成本:通过减少对昂贵GPU的需求,降低了硬件成本,使LLMs更易于个人和小型企业的访问。

- 本地运行:用户可以在本地设备上运行LLMs,减少对外部服务器的依赖,提高数据隐私和安全性。

2. 可持续性

- 减少碳足迹:通过降低能源消耗,减少了LLMs的碳足迹,促进了可持续性。

- 环境友好:高效的能源使用使得大规模部署LLMs更加环保。

3. 技术创新

- 新范式:bitnet.cpp重新定义了LLMs的计算范式,展示了如何在低资源需求下实现有效的推理。

- 未来方向:为开发针对1位LLMs优化的专用软件堆栈和硬件奠定了基础,推动了LLM技术的进一步发展。

未来展望

1. 持续研究

- 1位AI基础设施计划:微软启动了“1位AI基础设施”计划,旨在进一步推动1位LLMs的工业采用。

- 技术创新:持续的研究和开发将带来更多高效和可持续的AI解决方案。

2. 广泛应用

- 个人和企业:bitnet.cpp使得LLMs的访问更加民主化,促进了其在个人和企业中的广泛应用。

- 隐私保护:本地运行LLMs可以最大限度地减少数据外泄的风险,保护用户隐私。

结论

bitnet.cpp代表了使LLM技术更易访问、高效和环保的重大飞跃。通过显著的加速和能源消耗的减少,bitnet.cpp使得在标准CPU硬件上运行大型模型成为可能,打破了依赖昂贵且耗电的GPU的局面。这一创新可能使LLMs的访问民主化,并促进其在本地使用的采用,最终为个人和行业解锁新的可能性。随着微软继续推进其1位LLM研究和基础设施计划,更多可扩展和可持续的AI解决方案的潜力变得日益有希望。