GLM-4-Voice 是智谱 AI 推出的一个先进的端到端语音模型,能够直接理解和生成中英文语音,进行实时语音对话,并且能够根据用户的指令改变语音的情感、语调、语速和方言等属性。

组成部分

GLM-4-Voice 由三个主要部分组成:

- GLM-4-Voice-Tokenizer:

- 功能:通过在 Whisper 的 Encoder 部分增加 Vector Quantization(VQ)并在 ASR 数据上有监督训练,将连续的语音输入转化为离散的 token。

- 特点:每秒音频平均只需要用 12.5 个离散 token 表示,大大降低了数据传输和处理的复杂度。

- GLM-4-Voice-Decoder:

- 功能:基于 CosyVoice 的 Flow Matching 模型结构训练的支持流式推理的语音解码器,将离散化的语音 token 转化为连续的语音输出。

- 特点:最少只需要 10 个语音 token 即可开始生成,显著降低了端到端对话的延迟。

- GLM-4-Voice-9B:

- 功能:在 GLM-4-9B 的基础上进行语音模态的预训练和对齐,从而能够理解和生成离散化的语音 token。

- 特点:基于强大的基座模型,经过了数百万小时音频和数千亿 token 的音频文本交错数据预训练,具备强大的音频理解和建模能力。

模型地址

| Model | Type | Download |

|---|---|---|

| GLM-4-Voice-Tokenizer | Speech Tokenizer | Huggingface ModelScope |

| GLM-4-Voice-9B | Chat Model | Huggingface ModelScope |

| GLM-4-Voice-Decoder | Speech Decoder | Huggingface ModelScope |

预训练

为了克服模型在语音模态下的智商和合成表现力两个难题,智谱 AI 将 Speech2Speech 任务解耦合为两个子任务:

- 根据用户音频做出文本回复:

- 预训练目标:基于文本预训练数据,训练模型理解用户音频并生成相应的文本回复。

- 根据文本回复和用户语音合成回复语音:

- 预训练目标:基于无监督音频数据,合成语音-文本交错数据,适配模型生成高质量的回复语音。

通过这种方式,GLM-4-Voice-9B 在 GLM-4-9B 的基座模型基础之上,经过了大量的音频和文本数据预训练,具备了强大的音频理解和生成能力。

对齐

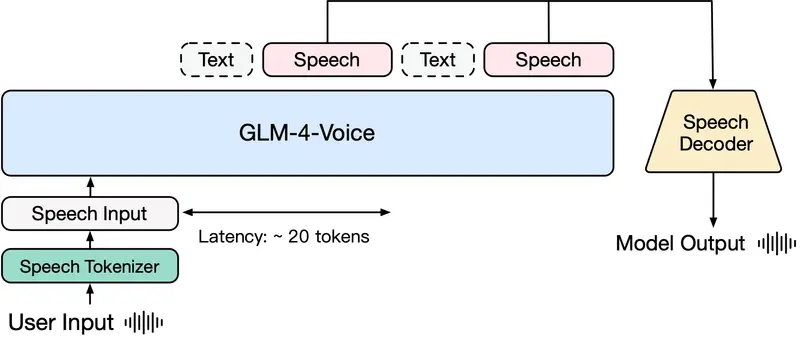

为了支持高质量的语音对话,智谱 AI 设计了一套流式思考架构:

- 流式交替输出:根据用户语音,GLM-4-Voice 可以流式交替输出文本和语音两个模态的内容。

- 高质量回复:语音模态以文本作为参照,确保回复内容的高质量。

- 声音变化:根据用户的语音指令要求,模型可以做出相应的声音变化。

- 低延迟:模型具备端到端建模的能力,最低只需要输出 20 个 token 便可以合成语音,确保了低延迟性。

GLM-4-Voice 是一个功能强大、高度灵活的端到端语音模型,能够在多种场景下提供高质量的语音对话服务。其独特的设计和预训练方法使其在语音理解和生成方面表现出色,适用于智能客服、语音助手、虚拟主播等多种应用场景。如果你需要一个能够理解和生成自然语音的模型,GLM-4-Voice 是一个值得尝试的选择。