最近的大规模文本到语音(TTS)系统通常被分为自回归和非自回归系统。自回归系统隐式地建模持续时间,但在鲁棒性和持续时间可控性方面存在某些缺陷。非自回归系统在训练期间需要文本和语音之间的显式对齐信息,并预测语言单元(例如音素)的持续时间,这可能会损害它们的自然度。

引入MaskGCT

为了解决这些问题,香港中文大学(深圳)和广州趣闯网络科技的研究人员提出了 Masked Generative Codec Transformer (MaskGCT),这是一个完全非自回归的新型零样本TTS模型。MaskGCT 消除了在文本和语音监督之间以及音素级持续时间预测的显式对齐信息的需求。

- 官网:https://voice.funnycp.com

- GitHub:https://github.com/open-mmlab/Amphion/tree/main/models/tts/maskgct

- 模型:https://huggingface.co/amphion/MaskGCT

- Demo:https://huggingface.co/spaces/amphion/maskgct

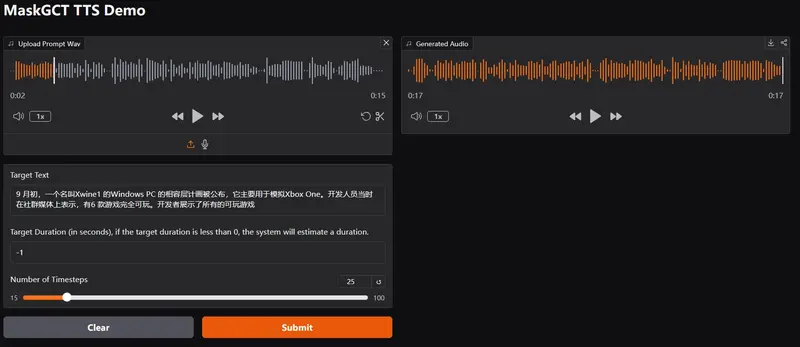

MaskGCT能够将文本转换为语音,而无需针对特定说话者的训练数据。MaskGCT的核心在于其创新的非自回归(non-autoregressive)生成模型,它通过预测语义令牌(semantic tokens)和声学令牌(acoustic tokens)来合成语音,无需显式的文本与语音对齐信息和音素级(phone-level)时长预测。

例如你想为一个多语言的有声读物应用生成一段语音,其中包含了来自不同语言的文本。使用MaskGCT,你只需提供文本内容,系统便能自动将其转换为相应语言的语音输出,同时保持自然度和说话者的音色。

主要功能和特点

- 零样本学习能力:MaskGCT能够在没有特定说话者样本的情况下生成高质量的语音。

- 无需对齐信息:与需要精确文本和语音对齐的传统TTS系统不同,MaskGCT不需要这种对齐信息。

- 自然度和相似度高:MaskGCT生成的语音在自然度、相似度和可懂度方面优于现有的零样本TTS系统。

- 控制语音时长:MaskGCT能够灵活控制生成语音的总时长,这对于跨语言配音(如电影配音)尤为重要。

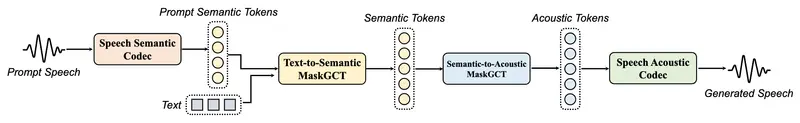

工作原理

MaskGCT分为两个阶段:

- 文本到语义(T2S)模型:该模型使用文本预测从语音自监督学习(SSL)模型中提取的语义令牌。

- 语义到声学(S2A)模型:该模型基于预测的语义令牌来预测声学令牌,这些令牌随后被用来重建语音波形。

MaskGCT遵循“掩码和预测”的学习范式,在训练期间学习预测被掩码的语义或声学令牌,而在推理阶段则并行生成指定长度的令牌序列。

学习范式

MaskGCT 遵循掩蔽和预测的学习范式:

- 训练期间:MaskGCT 学习根据给定的条件和提示预测掩蔽的语义或声学 tokens。

- 推理期间:模型以并行方式生成指定长度的 tokens。

实验结果

在野外语音的10万小时实验表明,MaskGCT 在质量、相似性和可理解性方面优于当前的最新零样本 TTS 系统。

实验设置

- 数据集:10万小时的野外语音数据。

- 评估指标:质量、相似性和可理解性。

实验结果表明,MaskGCT 在以下几个方面表现优越:

- 质量:生成的语音质量高,自然流畅。

- 相似性:生成的语音与原始语音高度相似。

- 可理解性:生成的语音易于理解,口齿清晰。

具体应用场景

- 有声读物:为电子书或在线文章生成语音版本,提供更丰富的用户体验。

- 多语言配音:在电影、视频游戏和广告中,为不同语言版本生成配音。

- 语音助手:为智能设备提供自然听起来的语音反馈,增强交互体验。

- 语言学习:生成标准发音的语音示例,帮助语言学习者练习发音和听力。

- 新闻和播客:自动生成新闻报道或播客内容的语音版本,提高内容发布的效率。