文章目录[隐藏]

随着大语言模型(LLMs)在各个领域的广泛应用,数据隐私和安全成为越来越多企业和个人用户关心的重点。为了满足这些需求,一系列本地运行的LLM工具应运而生,让用户能够在不依赖外部云服务的情况下,安全高效地利用先进的AI技术。

以下是六款优秀的本地LLM工具,它们不仅提供了强大的功能,还确保了用户数据的安全性和隐私。

一、为何使用本地LLMs

- 隐私保障:如LM Studio运行本地LLMs时不收集用户数据,聊天数据留本地,不与AI/ML服务器共享,可在本地主机多轮提示。

- 自定义选项丰富:本地LLMs提供CPU线程、温度、上下文长度、GPU设置等高级配置,类似OpenAI的playground。

- 支持与安全性良好:能提供与OpenAI或Claude类似的支持和安全性。

- 免费且节省成本:工具免费使用,无每月订阅费用,与OpenAI云服务每次API请求需付费不同,可节省资金。

- 离线支持:离线时可加载和连接大语言模型。

- 连接稳定性强:避免连接云服务时可能出现的信号和连接不良问题。

二、六大免费本地LLM工具

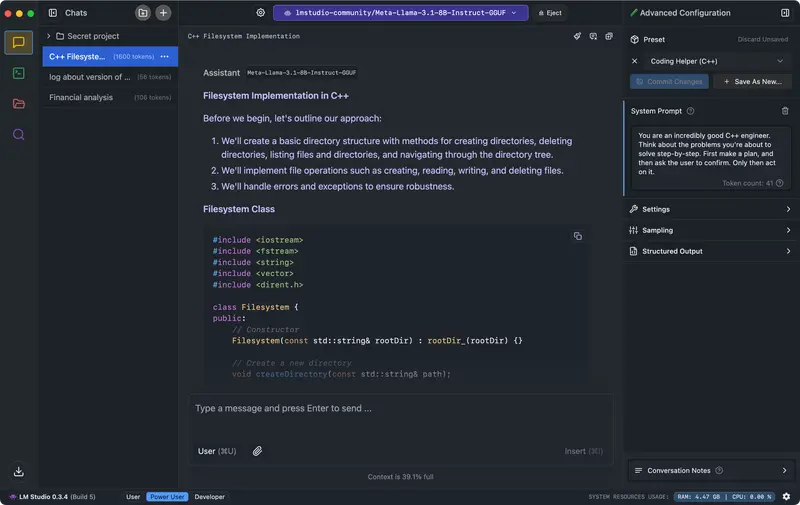

(一)LM Studio

- 功能概述

- 可运行gguf格式模型文件,支持Llama 3.1、Phi 3、Mistral和Gemma等模型提供商的文件。

- 启动后主页展示可供下载和测试的顶级LLMs,有搜索栏可过滤和下载特定模型,根据机器兼容性猜测突出显示可工作模型。

- 关键特性

- 模型参数自定义:可调整温度、最大Token、频率惩罚等。

- 聊天历史:能保存提示供后续使用。

- 参数和UI提示:鼠标悬停信息按钮可查模型参数和术语。

- 跨平台:适用于Linux、Mac和Windows操作系统。

- 机器规格检查:检查计算机规格如GPU和内存,报告兼容模型,防止下载无法工作的模型。

- AI聊天和Playground:以多轮聊天格式与大语言模型聊天,可同时加载多个LLMs实验。

- 开发者本地推理服务器:允许开发者设置本地HTTP服务器,提供示例Curl和Python客户端请求,便于构建AI应用程序访问特定LLM,还可导入OpenAI Python库并将基本URL指向本地服务器。

- 使用好处

- 个人使用免费,开发者可通过应用内聊天UI和Playground运行LLMs,界面华丽易用,支持过滤,可连接OpenAI Python库无需API密钥。公司和企业需请求后使用,但要求M1/M2/M3 Mac或更高版本,或支持AVX2的Windows PC,Intel和AMD用户在v0.2.31中限于使用Vulkan推理引擎。

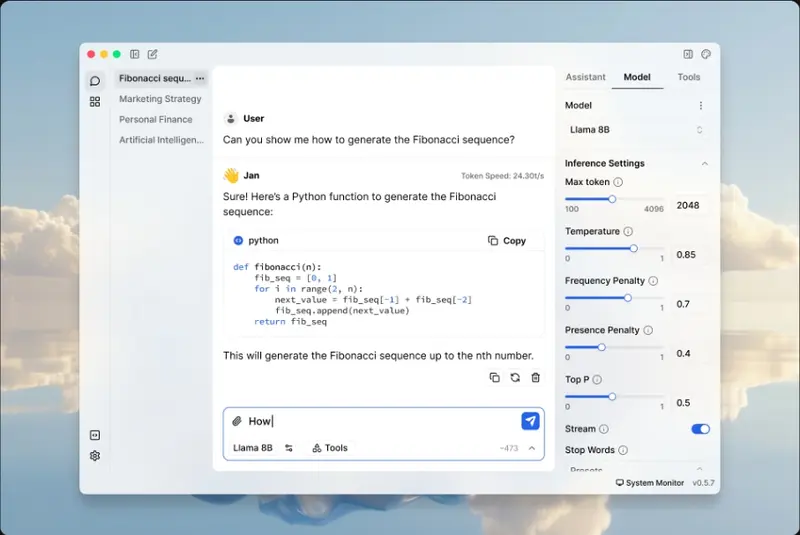

(二)Jan

- 功能概述

- 可视为离线开源版ChatGPT,由用户社区构建,秉持用户所有理念,能在设备上离线运行Mistral或Llama等流行模型,也可访问远程API如OpenAI和Groq。

- 关键特性

- 本地运行:无需联网在设备上运行喜欢的AI模型。

- 现成模型:下载后有一组已安装模型,还可搜索特定模型。

- 模型导入:支持从Hugging Face等来源导入模型。

- 免费、跨平台和开源:完全免费、开源,适用于Mac、Windows和Linux。

- 自定义推理参数:可调整最大Token、温度、流、频率惩罚等,所有偏好和设置本地保存。

- 扩展:支持TensorRT和Inference Nitro等扩展。

- 使用好处

- 提供干净简单界面与LLMs交互,数据和处理信息本地保留,已安装七十多种大语言模型,便于连接和与远程API交互,有良好的GitHub、Discord和Hugging Face社区,不过模型在Apple Silicon Mac上运行速度比Intel快。

(三)Llamafile

- 工作原理

- 将LLMs转换为多平台可执行链接格式(ELF),通过tinyBLAST在Windows等操作系统上无需SDK运行,只需一个可执行文件即可在多种架构上运行。

- 关键特性

- 可执行文件:与其他工具不同,仅需一个可执行文件运行LLMs。

- 使用现有模型:支持使用Ollama和LM Studio等现有模型工具。

- 访问或创建模型:可访问OpenAI、Mistral、Groq等流行LLMs,也支持从头创建模型,还能将.gguf等格式文件转换为.llamafile。

- 使用步骤

- 访问Huggingface网站,从导航选Models并搜索Llamafile,或从URL安装喜欢的量化版本。

- 下载Llamafile,若有wget实用程序,可使用命令下载。

- 使下载的Llamafile可执行,使用命令导航到文件位置并使其可执行。

- 运行Llamafile,在文件名前加./启动,应用将在http://127.0.0.1:8080运行LLMs。

- 使用好处

- 普及AI和ML,提供最快提示处理体验和在游戏计算机上的更好性能,适合总结长文本和大文档,100%离线私密运行,机器学习社区支持其格式,有开源社区进一步开发扩展。

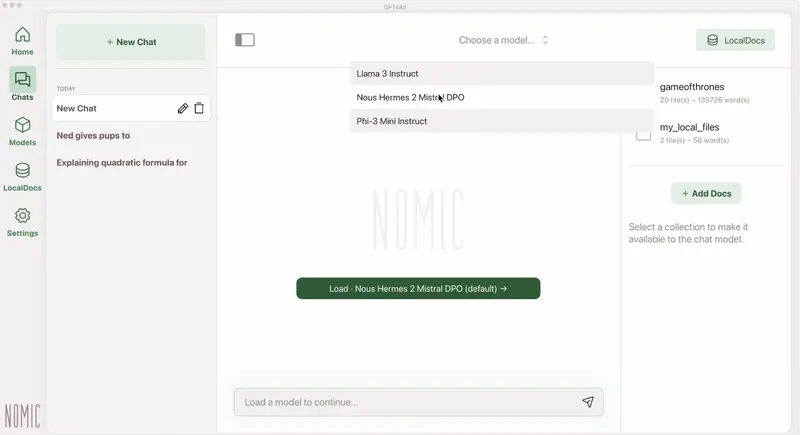

(四)GPT4ALL

- 功能概述

- 基于隐私、安全和无需互联网原则,可在Mac、Windows和Ubuntu上安装,月下载量、GitHub Stars和活跃用户较多。

- 关键特性

- 隐私优先:私密敏感聊天信息和提示留本地。

- 无需互联网:完全离线工作。

- 模型探索:开发者可浏览下载不同LLMs实验,有约1000个开源语言模型可选。

- 本地文档:让本地LLM访问敏感数据如.pdf和.txt,数据不离设备且无需网络。

- 自定义选项:提供多种聊天机器人调整选项。

- 企业版:有企业包,包含安全、支持和每设备许可证。

- 使用好处

- 除Ollama外GitHub贡献者最多,月活跃用户约250000,应用收集匿名用户数据但可选择加入或退出,开发者受益于其庞大用户群、GitHub和Discord社区。

(五)Ollama

- 功能概述

- 可轻松创建本地聊天机器人,无需连接OpenAI等API,本地运行无需订阅费和API调用费。

- 关键特性

- 模型自定义:可转换.gguf模型文件并运行。

- 模型库:有大型模型集合可尝试。

- 导入模型:支持从PyTorch导入模型。

- 社区集成:无缝集成到多种Web和桌面应用程序。

- 数据库连接:支持多个数据平台。

- 移动集成:SwiftUI应用Enchanted和跨平台Flutter应用Maid可将其带到不同系统。

- 使用步骤

- 首次使用访问https://ollama.com下载适用于机器的版本,可在Mac、Linux或Windows安装,安装后在终端查看详细信息。

- 运行特定LLM,使用命令下载,如ollama pull modelname,下载后运行ollama run modelname启动模型。

- 使用好处

- GitHub有超过200个贡献者,更新活跃,贡献者数量在开源LLM工具中最多,更具可扩展性。

(六)LLaMa.cpp

- 功能概述

- 是支持本地LLM工具如Ollama等的底层后端技术(推理引擎),支持在各种硬件上进行最小配置和出色本地性能的大语言模型推理,也可在云中运行。

- 关键特性

- 设置:设置简单,一个命令即可安装。

- 性能:在各种硬件本地和云中表现好。

- 支持的模型:支持Mistral 7B、Mixtral MoE、DBRX、Falcon等流行LLMs。

- 前端AI工具:支持开源LLM UI工具如MindWorkAI/AI - Studio(FSL - 1.1 - MIT)、iohub/collama等。

- 使用步骤

- 使用命令安装,从Hugging Face或其他来源下载要运行的模型,进入模型文件位置运行命令,调用LLaMa CLI工具并设置相关标志指定模型路径和提示,运行后可看到结果。

三、评估本地运行的LLMs的性能

- 查看模型训练数据集。

- 了解模型定制和微调程度以执行特定任务或针对特定领域的能力。

- 查看LLM是否有学术研究论文。可参考Hugging Face和Arxiv.org等资源,以及Open LLm Leaderboard和LMSYS Chatbot Arena提供的基准信息。

本地运行的大语言模型工具为用户提供了一种既保持数据隐私又不失功能灵活性的选择。无论是个人开发者、小团队还是大型企业,都可以根据自身需求选择合适的工具。这些工具不仅推动了AI技术的普及和发展,同时也保障了用户数据的安全性和私密性。