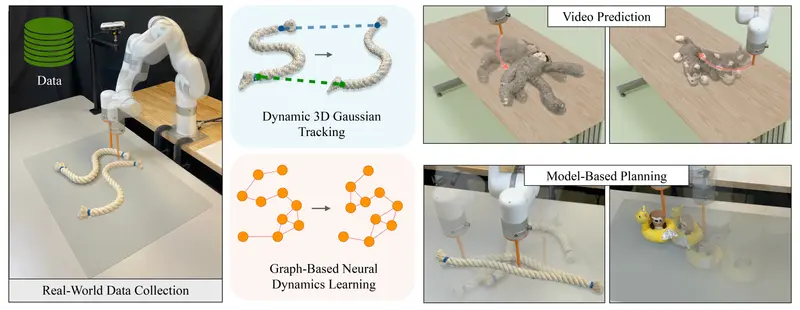

伊利诺伊大学厄巴纳-香槟分校和哥伦比亚大学的研究人员推出基于动态3D高斯跟踪的图神经动力学建模框架gs-dynamics,旨在通过分析机器人与物体交互的视频来学习物体的动态特性。这个框架特别关注于从多视角RGB视频中直接学习物体的3D动态,并显式考虑机器人动作轨迹及其对场景动态的影响。

- 项目主页:https://gs-dynamics.github.io

- GitHub:https://github.com/robo-alex/gs-dynamics

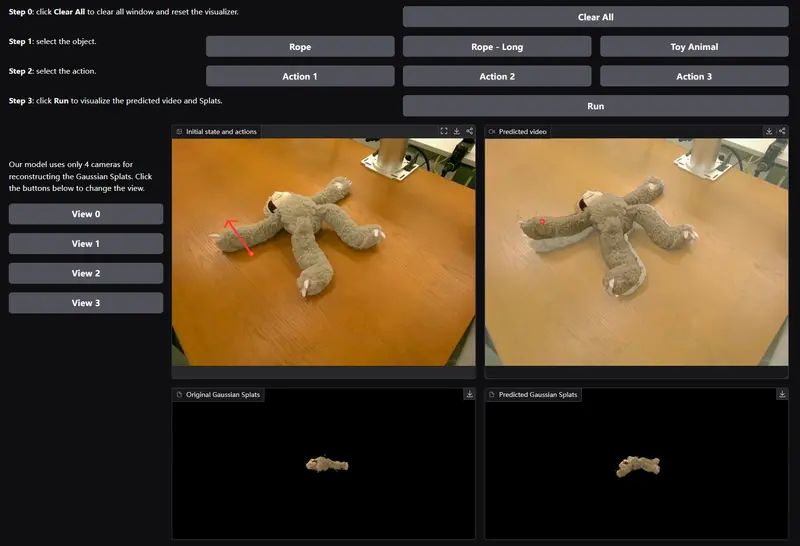

- Demo:https://huggingface.co/spaces/kaifz/gs-dynamics

假设你是一个机器人工程师,需要让机器人能够预测和适应与各种可变形材料(如绳子、衣服和填充玩具)的交互。使用这个框架,你可以通过提供机器人与这些物体交互的视频,让机器人学习如何根据以往的交互数据预测物体在不同初始配置和未见过的机器人动作下的运动。

主要功能和特点

- 3D高斯表示:利用3D高斯表示(3DGS)来训练基于粒子的动力学模型,这个模型使用图神经网络(GNNs)。

- 动态3D高斯跟踪:通过优化3D高斯的时空运动,实现对动态场景的拟合。

- 显式物理约束:框架整合了几何先验,提出了一种新颖的方法来注入相机姿态,增强模型对物理世界的理解。

- 图神经网络:在控制粒子的空间图上操作,预测物体在外部动作(如机器人交互)下的运动。

- 高斯变换插值:从稀疏控制粒子的动态中计算3D高斯的变换,实现动作条件视频预测。

- 模型基规划:动力学模型也可以应用于模型基规划框架,如模型预测控制,用于物体操作任务。

工作原理

- 数据收集:使用机器人与物体交互的多视角视频作为数据源。

- 3D高斯优化:通过动态3D高斯溅射(Dyn3DGS)框架获得粒子基础表示。

- 图神经网络训练:在控制粒子的图上训练GNN,预测物体运动。

- 动作条件视频预测:使用控制粒子的运动来插值密集的高斯核运动和旋转,实现视频预测。

- 模型基规划:利用学习到的动力学模型进行模型基规划,如MPC,以实现精确的机器人操作。

具体应用场景

- 机器人交互预测:在机器人与可变形物体(如衣物、绳索)的交互中预测物体的运动。

- 视频预测:生成基于特定动作条件的未来视频帧,用于模拟和训练。

- 模型基规划:在机器人操作任务中,如物体搬运和定位,使用学习到的动力学模型进行精确规划。

- 增强现实和虚拟现实:在AR/VR应用中,根据用户的交互动作实时预测和渲染物体的动态响应。