文章目录[隐藏]

在人工智能和机器学习快速发展的世界中,对强大、灵活和开放访问解决方案的需求急剧增长。开发人员、研究人员和技术爱好者在利用尖端技术时经常面临挑战,而这些技术往往受到封闭生态系统的限制。许多现有的语言模型,即使是那些最受欢迎的模型,通常也带有专有局限性和许可限制,或者托管在阻碍开发者所需细粒度控制的环境中。这些问题常常成为那些热衷于以特定方式实验、扩展或部署模型的人的障碍。开源解决方案成为关键推动者,提供自主权并使强大的AI工具民主化。

AMD OLMo 的发布

AMD最近发布了 AMD OLMo:一个完全开源的1B模型系列,由AMD在AMD Instinct™ MI250 GPU上从头开始训练。AMD OLMo 的发布标志着AMD首次在开源AI生态系统中的重大进入,提供了一个完全透明的模型,适用于开发人员、数据科学家和企业。

模型:https://huggingface.co/amd/AMD-OLMo-1B-SFT

技术细节

模型架构和参数:

- Transformer 架构:AMD OLMo 采用transformer架构,拥有10亿个参数,提供显著的语言理解和生成能力。

- 多样化数据集:该模型在一个多样化的数据集上进行了训练,以优化其在各种自然语言处理(NLP)任务中的性能,如文本分类、摘要和对话生成。

微调和优化:

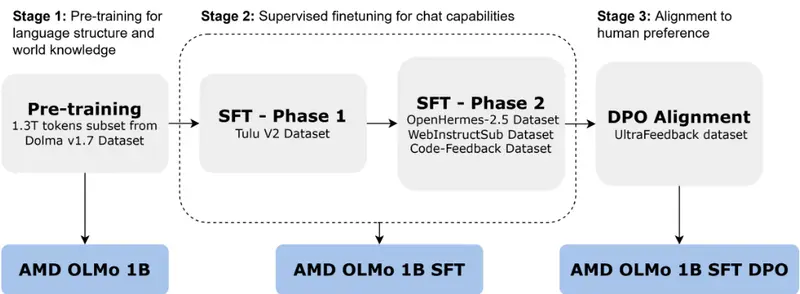

- 指令跟随微调:AMD OLMo-1B-SFT(监督微调)特别微调以增强其理解指令的能力,改善用户交互和语言理解。

- 高性能硬件:AMD在训练过程中使用高性能Radeon Instinct GPU,展示了其硬件处理大规模深度学习模型的能力。

- 计算效率:该模型已针对准确性和计算效率进行了优化,使其能够在消费级硬件上运行,而无需与专有大规模语言模型相关的庞大资源需求。

适用性和兼容性

用例:

- 对话AI任务:支持基本的对话AI任务。

- 复杂NLP问题:处理更复杂的NLP问题,如文本分类、摘要和对话生成。

- 现实应用场景:适用于聊天机器人、客户支持系统和教育工具。

框架兼容性:

- PyTorch 和 TensorFlow:与标准机器学习框架兼容,确保不同平台的用户易于访问。

重要性

降低准入门槛:

- 民主化AI:通过向所有人提供一个完全开放的1B参数模型,AMD正在提供一个关键资源,可以赋能全球的开发者。

- 现实场景增强:AMD OLMo-1B-SFT经过指令跟随微调,允许在各种现实场景中增强可用性。

性能表现:

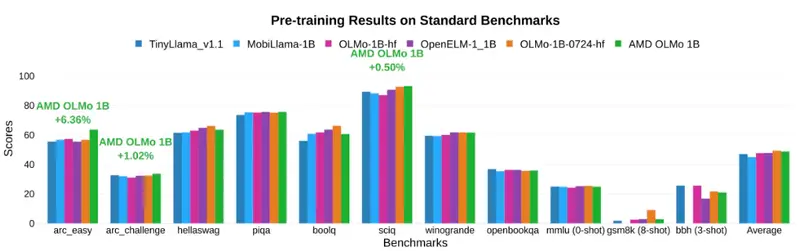

- 基准测试:初步基准测试表明,AMD OLMo在与类似规模的知名模型竞争中表现出色,在多个NLP基准测试中表现强劲,包括GLUE和SuperGLUE。

- 透明度和协作:在开源环境中提供这些结果至关重要,因为它使社区能够独立验证、测试和改进,确保透明度并促进协作方式,推动这些模型所能达到的边界。

结论

AMD推出完全开源的1B语言模型是AI社区的一个重要里程碑。这一发布不仅使高级语言建模能力民主化,还提供了一个实际演示,展示了如何使强大的AI更具包容性。AMD对开源原则的承诺有可能激励其他科技巨头做出类似的贡献,培养一个更丰富的工具和解决方案生态系统,使每个人受益。通过提供一个强大、成本效益高且灵活的语言理解和生成工具,AMD成功地将自己定位为未来AI创新的关键参与者。