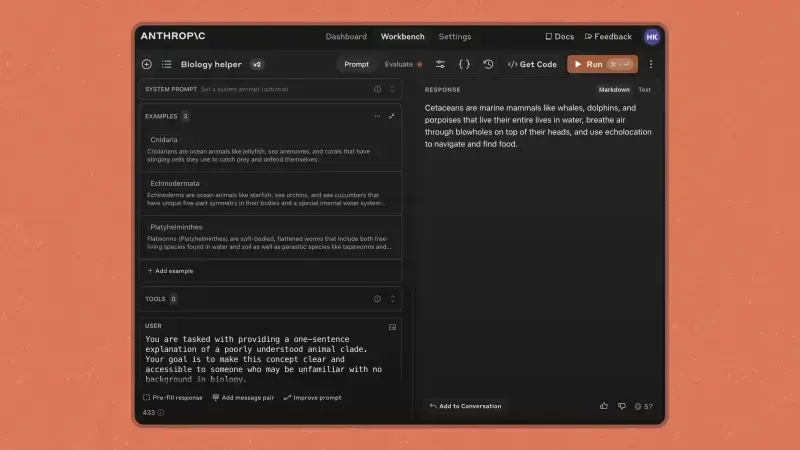

Anthropic AI 推出了新的控制台功能,旨在将控制权交还给开发者,使使用 Claude 构建可靠的 AI 应用程序变得更加简单。Anthropic 控制台允许用户使用 Anthropic API 构建应用程序,对开发者尤其有用。您可以将 Anthropic 控制台视为公司的助手。

开发者可以使用 Anthropic 控制台进行以下操作:

- 与 Anthropic API 交互:轻松管理和调用 API。

- 管理 API 使用和成本:监控和控制 API 的使用情况和费用。

- 构建和改进提示:为 Claude 或其他 AI 系统创建和优化提示。

- 在不同场景下测试提示:确保提示在各种情况下都能有效工作。

- 简化提示生成和评估过程:提高提示的质量和效率。

- 生成测试套件:创建和管理测试用例。

提示质量的重要性

提示质量在 AI 响应的成功中起着关键作用。然而,掌握提示工程可能既耗时又因不同的 AI 模型而异。Anthropic AI 的提示改进器可以帮助开发者自动改进现有的提示,使用先进的技术适应不同模型的提示或优化手写提示。

提示改进器的功能

- 思维链推理:为 Claude 添加一个部分,使其能够系统地思考问题,提高准确性和可靠性。

- 示例标准化:将示例转换为一致的可扩展标记语言(XML)格式,提高清晰度和数据共享能力。

- 示例丰富:通过与新提示结构一致的推理来改进示例。

- 重写:澄清结构并纠正轻微的语法或拼写错误。

- 预填充添加:助手消息预填充,指导 Claude 的行动并执行输出格式。

显著的改进效果

根据 Anthropic 的测试,提示改进器在多标签分类测试中将准确性提高了 30%,在总结任务中实现了 100% 的单词计数合规性。

示例管理的重要性

向提示添加示例是改进 AI 响应的最佳方法之一,有助于 Claude 精确遵循特定格式。现在,您可以在 Workbench 中以结构化格式管理示例,方便添加新示例或编辑现有示例,提高响应质量。

自动生成示例

如果您的提示缺乏示例,Claude 可以自动创建合成输入和草稿输出,简化提示生成过程。

提示评估器

提示评估器允许您在不同场景下测试提示,并在评估选项卡中添加了一个可选的“理想输出”列,以基准测试和改进性能。这有助于用户在 5 分制上持续评估模型输出。

持续优化

测试后,您可以向 Claude 提供更多关于提示改进的反馈,并重复该过程,直到满意为止。Claude AI 还可以根据请求修改提示和示例。例如,您可以要求 JSON 格式的输出而不是 XML。(来源)