AI领域迎来了一个新工具——AnyChat,它通过将多个领先的大型语言模型(LLMs)整合在一个界面下,为开发者提供了前所未有的灵活性。这个平台由Gradio的机器学习增长负责人Ahsen Khaliq(也称为“AK”)开发,允许用户在ChatGPT、谷歌的Gemini、Perplexity、Claude、Meta的LLaMA和Grok等模型之间无缝切换,而无需锁定在单一提供商。

AnyChat的核心优势:

- 灵活性与控制: AnyChat的设计旨在使开发者更容易实验和部署不同的LLMs,而无需传统平台的限制。用户可以自由地集成来自不同来源的模型,无论是专有模型还是开源选项。

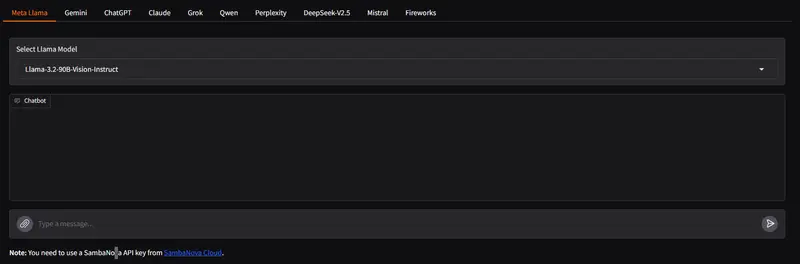

- 基于标签的界面: 平台具有基于标签的界面,允许用户轻松在模型之间切换,并带有下拉菜单用于选择每个AI的特定版本。

- 令牌认证: AnyChat支持令牌认证,确保企业用户对API的安全访问。

- 统一界面: AnyChat通过提供一个可以处理专有和开源模型的统一界面,解决了开发者在承诺单一模型或花费大量时间和资源分别集成多个模型之间的选择难题。

- 社区驱动: AnyChat的真正力量在于它的成长能力,社区可以扩展它,添加新模型,使这个平台的潜力远远超过任何一个模型。

AnyChat的应用场景:

- 多模型部署: 用户可以在同一个应用程序中部署多个模型,而无需为每个模型构建单独的基础设施。

- 实时搜索和多模态功能: 集成到AnyChat中的Perplexity模型提供实时搜索功能,而像LLaMA 3.2这样的模型提供视觉支持,扩展了平台在文本AI之外的能力。

AnyChat的开源支持:

AnyChat支持Hugging Face上托管的广泛模型,使开发者对其部署有更多控制,并避免与专有模型相关的昂贵API费用。

AnyChat的多模态AI支持:

AnyChat最令人兴奋的方面之一是其对多模态AI的支持,即可以处理文本和图像的模型。这一功能变得越来越重要,从分析图像用于诊断目的到从视觉数据生成基于文本的见解。

AnyChat的未来展望:

Khaliq相信,平台的开放架构将鼓励更多开发者贡献模型,使其随着时间的推移变得更加强大。社区已经拥抱了这一愿景,随着对DeepSeek V2.5等模型的支持已经集成,AnyChat有望成为AI实验和部署的中心。