文章目录[隐藏]

背景

在当今日益互联的世界中,跨语言的有效沟通变得尤为重要。然而,许多自然语言处理(NLP)模型在处理不常见的语言时仍然面临挑战,尤其是在泰语、蒙古语和柬埔寨语等低资源语言中。这些语言缺乏像英语和中文那样的数据和处理基础设施,导致传统NLP模型在多语言应用中的表现受限。

Xmodel-1.5简介

Xmodel-1.5是由晓多科技的人工智能实验室开发的多语言模型,拥有10亿参数,预训练于约2万亿个标记。该模型旨在提供一个能够在多种语言中表现出色的包容性NLP解决方案,特别关注高资源和低资源语言的表现。为了支持低资源语言理解的研究,团队还发布了一个由朱拉隆功大学集成创新学院学生注释的泰语评估数据集。

技术细节和优势

- 多样化语料库:

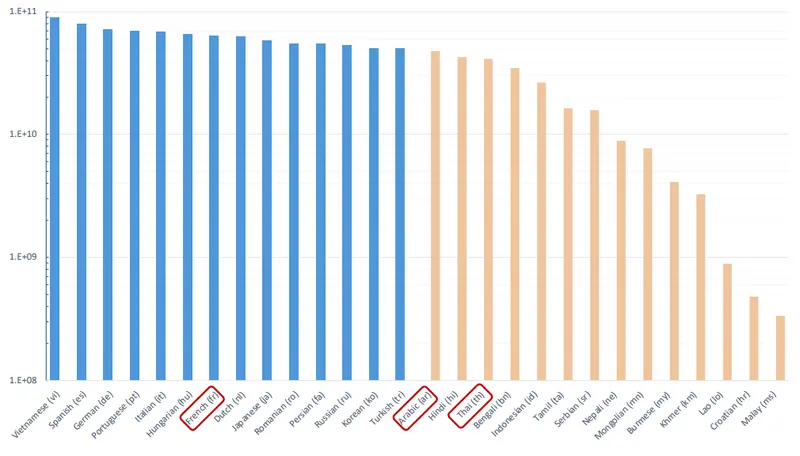

- Xmodel-1.5在多语言维基、CulturaX和其他特定语言数据集等来源的多样化语料库上进行训练,确保了其在多种语言中的泛化能力。

- unigram分词器:

- 使用专门训练的unigram分词器,产生了一个包含65,280个标记的词汇表。分词器在效率和语言覆盖之间取得了平衡,适用于多语言任务,包括那些拼写不太规范的任务。

- 模型架构:

- 旋转位置嵌入(RoPE):提高模型对位置信息的敏感度。

- RMS归一化:提高训练稳定性。

- SwiGLU激活:优化性能。

- 分组查询注意力:提高训练和推理效率。

- 数据分布策略:

- 采用了一种数据分布策略,确保在训练过程中充分代表低资源语言,使其在高资源和低资源语言中都能表现优异。

- 指令微调:

- 经过指令微调,进一步提高了模型的熟练度,特别是在电子商务领域的检索增强生成(RAG)任务中,满意度率达到92.47%。

Xmodel-1.5的意义

- 多语言能力:

- Xmodel-1.5因其多语言能力和对代表性不足的语言社区的关注而脱颖而出。泰语、阿拉伯语和其他语言的纳入突显了其弥合高资源和低资源语言之间差距的承诺。

- 泰语评估数据集:

- 发布的泰语评估数据集为推进多语言NLP研究提供了宝贵的基准。

- 性能表现:

- 与OPT、Pythia和TinyLLaMA等基线模型相比,Xmodel-1.5在多个多语言任务中表现出色,特别是在常识推理方面。

- 在多语言任务中,Xmodel-1.5取得了强劲的结果,超越了PolyLM-1.7B。例如,它在HellaSwag的阿拉伯语变体和Belebele基准的泰语子集中的表现高于其竞争对手,展示了有效的多语言能力。