背景与挑战

训练大语言模型(LLM)是企业中最昂贵和耗时的任务之一。随着AI模型规模的不断扩大,训练成本和时间也随之增加,这对企业的资源提出了巨大挑战。ServiceNow 今天发布了一项新的开源技术——Fast-LLM,旨在通过优化现有训练资源的效率,将训练速度提高20%,从而为企业节省大量时间和金钱。

Fast-LLM 的起源与发展

Fast-LLM 技术已经在ServiceNow内部开发中得到了广泛应用,帮助公司加速其自身的LLM训练工作。ServiceNow 使用 Fast-LLM 训练了其最新的 LLM StarCoder 2,该模型在今年早些时候发布,并且本身也是一个开源项目,受益于 Hugging Face、Nvidia 等公司的贡献。此外,ServiceNow 还使用 Fast-LLM 进行了大规模的万亿标记连续预训练以及微调操作。

由于 Fast-LLM 是开源的,任何企业和开发者都可以使用这项技术来加速 AI 训练,包括微调操作。它的设计目标是作为现有 AI 训练管道的即插即用替代品,只需进行最少的配置更改,即可显著提升训练效率。

Fast-LLM 的技术创新

Fast-LLM 的核心优势在于其对计算顺序和内存管理的创新优化,这使得它能够在现有的硬件基础设施上实现更高的训练效率。

- 广度优先管道并行(Breadth-First Pipeline Parallelism):

- 计算调度优化:Fast-LLM 引入了一种新的计算调度方法,称为“广度优先管道并行”。这种方法重新定义了 AI 训练过程中计算发生的顺序,确保在单个 GPU 内部或跨多个 GPU 之间,计算任务能够更高效地分布。

- Chapados 解释说:"这是围绕计算调度方式的基本科学创新,无论是在单个 GPU 内部还是跨多个 GPU。" 通过这种方式,Fast-LLM 能够最大限度地利用现有的计算资源,减少等待时间和瓶颈。

- 内存管理优化:

- 消除内存碎片化:在大规模训练操作中,内存会随着时间的推移逐渐碎片化,导致内存效率低下,无法充分利用所有可用内存。Fast-LLM 通过精心设计的内存管理机制,几乎完全消除了这种内存碎片问题。

- Chapados 表示:"我们在设计 Fast-LLM 时非常小心,几乎完全消除了训练这些大型语言模型时的内存碎片问题。" 这一创新确保了训练过程中内存的高效使用,进一步提升了整体训练速度。

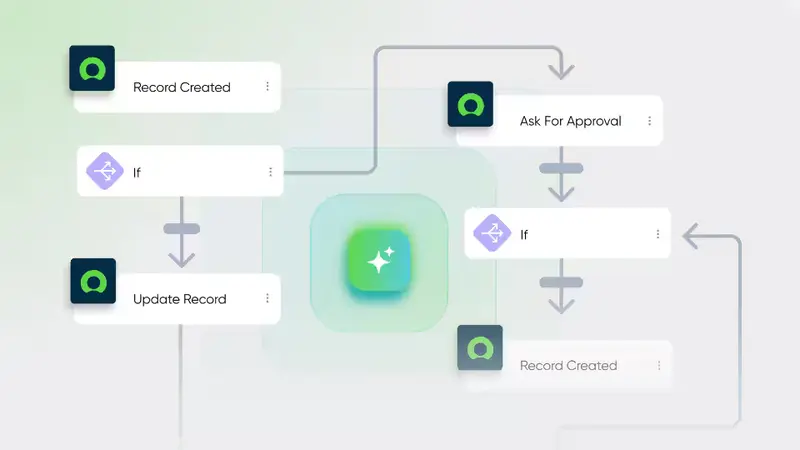

企业如何使用 Fast-LLM

Fast-LLM 框架的设计目的是易于访问,同时保持企业级功能。它可以作为 PyTorch 环境的即插即用替代品,并与现有的分布式训练设置无缝集成。对于任何模型开发者或研究人员来说,使用 Fast-LLM 只需要修改一个简单的配置文件,指定所有重要的架构细节。

- 降低训练风险:更快的训练操作降低了大规模训练运行的风险,减少了因长时间训练而导致的潜在问题。

- 更多实验机会:更快的训练速度使企业可以进行更多的实验,尝试更大规模的模型和更复杂的任务,而不必担心高昂的成本。

- Chapados 说:"它为用户、研究人员和模型构建者提供了更多的雄心,去训练更大的运行,因为他们不再担心成本问题。"

开源与社区贡献

作为开源项目,Fast-LLM 有望通过外部贡献快速扩展和发展。ServiceNow 已经在其 StarCoder 项目中成功采用了这种开源模式,未来也将继续推动 Fast-LLM 的透明性和社区参与。

- Chapados 强调:"我们的目标真的是非常透明和响应社区在使用这个框架方面的贡献。我们仍在收集早期反馈,了解人们喜欢什么,他们能用它做什么,我们的目标真的是扩展这一点。"

经济与环境效益

ServiceNow 研究副总裁 Nicolas Chapados 指出,当涉及到价值数亿的计算集群和每次训练运行成本数百万美元时,20%的节省在资金、时间和整体碳足迹方面都是巨大的。通过提高训练效率,Fast-LLM 不仅帮助企业节省了成本,还减少了能源消耗,有助于降低碳排放。