随着AI系统在社会各个领域的广泛应用,理解这些系统在现实世界中的影响变得至关重要。然而,分析用户数据以获取这些见解面临着伦理和隐私的重大挑战。手动检查原始对话不仅耗时且不可行,还可能引发隐私泄露和接触敏感内容的风险。为了应对这些挑战,Anthropic推出了Clio——一个隐私保护平台,旨在从广泛的对话中提取有意义的模式,同时尊重用户隐私。

Clio的设计理念

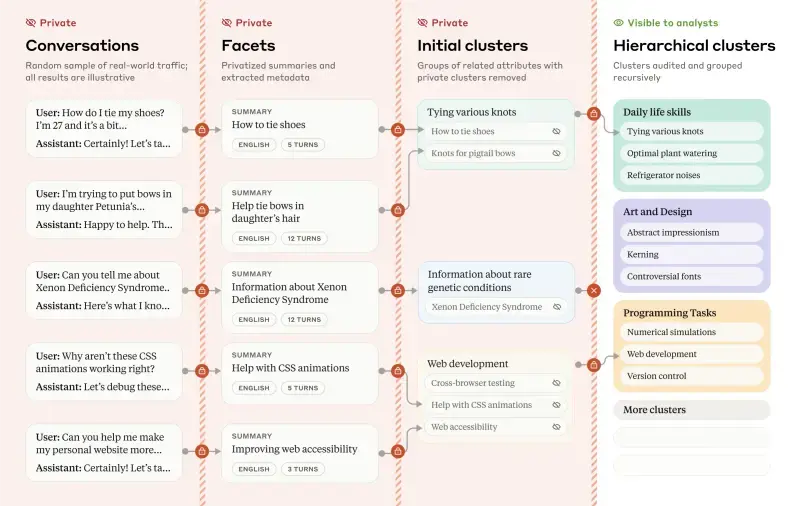

Clio的核心目标是在不侵犯个人隐私的前提下,提供对AI使用模式的深刻洞察。通过利用先进的自然语言处理(NLP)技术和聚类算法,Clio能够自动分析和汇总对话数据,生成高级别的、匿名化的见解。这种方法使得人类分析师只能访问经过处理的、去识别化的信息,从而最大限度地降低隐私风险。

技术细节

Clio的工作流程分为几个关键步骤,每个步骤都严格遵循隐私保护原则:

- 数据预处理:

- 去识别化:Clio首先从对话中删除所有可能识别用户的个人信息(PII),如姓名、地址、电子邮件等。这确保了即使在后续分析中,也无法追溯到具体的个体。

- 嵌入生成:使用NLP模型将对话转换为语义嵌入,捕捉对话的主题、情感、语言风格等特征。这些嵌入是高维向量,能够在不暴露原始文本的情况下表示对话的内容。

- 聚类分析:

- 主题聚类:Clio使用k-means等聚类算法将相似的对话嵌入分组,形成不同的主题类别。这些聚类可以是广义的(如“编码”、“商业任务”)或更具体的(如“老年护理讨论”)。聚类结果是分层次组织的,允许用户从宏观视角逐步深入到更细粒度的分析。

- 交互类型分类:除了主题,Clio还分析对话的交互类型,例如请求、命令、问题等,帮助理解用户与AI系统的互动方式。

- 可视化与探索:

- 交互式仪表盘:Clio提供了一个用户友好的交互式可视化工具,使分析师能够轻松探索不同主题和趋势。通过图表、热图和其他可视化手段,用户可以快速识别出重要的模式和异常情况。

- 趋势监测:Clio类似于Google Trends,提供了AI使用模式的总览,揭示了随着时间推移的趋势变化。这种功能特别适用于监控关键事件,如选举或其他社会热点话题。

- 隐私保护措施:

- 严格的访问控制:只有经过授权的人员才能访问Clio的分析结果,并且这些结果仅限于匿名化的、聚合的数据。

- 差分隐私:Clio采用了差分隐私技术,确保即使在极少数情况下,个别用户的对话数据也不会被泄露。差分隐私通过在数据中添加噪声来保护个体信息,同时保持整体模式的准确性。

洞察与结果

通过对一百万次Claude.ai对话的分析,Clio揭示了多个关于AI实际使用的显著洞察:

- 常见用例:Clio发现,用户最常见的用例包括编程(编码)、商业任务(如项目管理、市场分析)和写作(如文章创作、创意写作)。这些用例反映了AI在提高生产力和创造力方面的广泛适用性。

- 地域差异:不同国家和地区的用户表现出明显的兴趣差异。例如,日本用户经常讨论老年护理问题,这可能反映了该国人口老龄化带来的社会关注点。

- 误用模式:Clio还识别了一些误用模式,如协调的垃圾邮件生成和违反平台政策的行为。这些发现有助于Anthropic采取有针对性的干预措施,确保AI系统的安全和合规使用。

- 合成数据重建:Clio在重建合成数据集方面表现出94%的准确性,证明了其在生成隐私保护的洞察能力上的可靠性。