由浙江大学和阿里巴巴达摩院的研究团队提出了一种用于视觉语言预训练(VLP)的多模态教科书2.5 Years in Class,旨在解决现有视觉语言模型(VLM)预训练数据中存在的问题,如文本 - 图像关系松散、图像序列逻辑连贯性差和知识密度低等。

- 项目主页:https://multimodal-interleaved-textbook.github.io

- GitHub:https://github.com/DAMO-NLP-SG/multimodal_textbook

- 数据:https://huggingface.co/datasets/DAMO-NLP-SG/multimodal_textbook

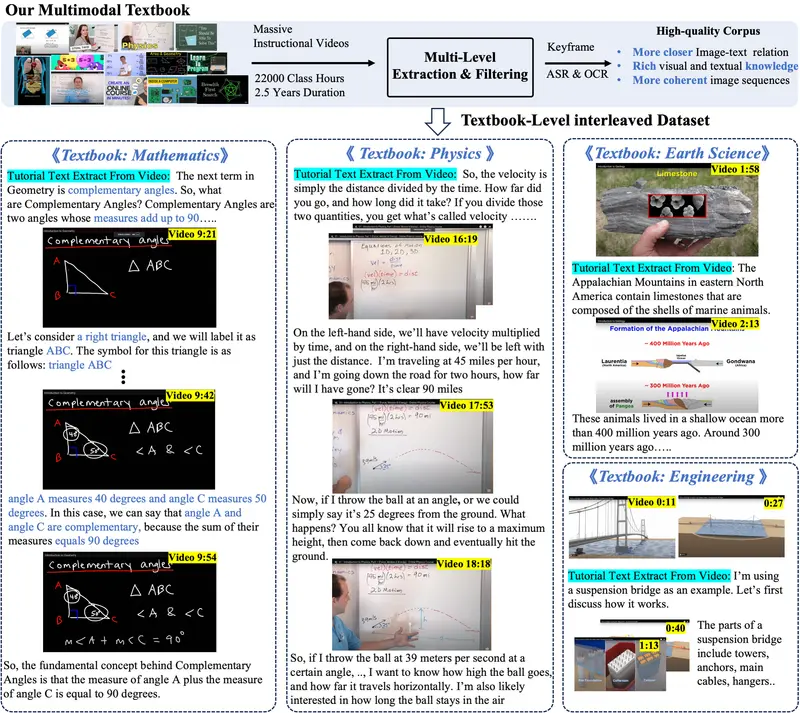

例如,考虑一个教学视频,它详细解释了物理学中的惯性概念。这个视频包含了讲师的讲解、动画演示以及相关的数学公式。通过这个项目,视频被转换成一系列图像(关键帧)和对应的文本(自动语音识别ASR和光学字符识别OCR),形成了一个图像-文本交织的语料库。这样的语料库可以帮助VLMs学习如何将视觉信息(如视频中的图像)与语言信息(如讲解和公式)结合起来,以理解和解释物理现象。

主要功能

- 构建高质量数据集:通过收集 2.5 年时长、共计 22,000 课时的教学视频,系统地提取和精炼视频中的视觉(关键帧)、听觉(自动语音识别,ASR)和文本知识(光学字符识别,OCR),构建了一个包含 650 万张高质量图像和 7.5 亿文本标记的大规模、高质量的多模态教科书数据集。

- 提供丰富知识和连贯上下文:以交错文本 - 图像格式组织数据,使文本与图像紧密对齐,图像序列逻辑关系更连贯,为 VLM 预训练提供丰富的基础知识和上下文信息,增强模型对复杂知识和推理逻辑的学习能力。

主要特点

- 知识丰富且密集:从教学视频中提炼出丰富的知识,涵盖数学、物理、化学等多个学科领域,相比现有数据集,具有更高的知识密度,有助于提升模型在知识和推理密集型任务上的表现。

- 图像 - 文本紧密关联:通过精心设计的处理流程,确保数据集中图像与文本的关系紧密,文本能够准确解释图像内容,且图像序列逻辑连贯,有效解决了以往交错数据集中图像 - 文本关系松散和逻辑不连贯的问题。

- 多模态信息融合:整合了视频中的视觉、听觉和文本信息,使模型能够从多个模态获取信息,更全面地理解和学习知识,提升模型的多模态理解和推理能力。

工作原理

- 数据收集

- 利用大语言模型(LLM)构建知识分类体系,涵盖 6 个学科、55 个课程和 3915 个知识点,基于此从 YouTube 上检索相关教学视频,并通过 LLM 对视频元数据进行筛选和去重,最终收集到 159,565 个教学视频。

- 视频到教科书的转换

- 视频层级处理:从视频中提取音频并转录为文本(ASR),使用 Qwen2 - 72B - Instruct 优化 ASR 文本,然后基于一系列规则和 LLM 评估过滤掉低质量视频,保留 75,000 个高质量视频。

- 片段层级处理:依据 ASR 转录的时间戳将长视频分割为短片段,确保文本与帧在时间上对齐。使用 VideoLlama2 为每个片段生成详细字幕,并通过计算字幕与 ASR 文本的相似度来过滤掉缺乏视觉知识的片段。

- 关键帧层级处理:通过比较连续帧之间的结构相似性指数(SSIM)提取关键帧,去除相似或重复的镜头,然后使用 InternVL2 进行光学字符识别(OCR),提取关键帧中的文本、符号和公式等信息,并过滤掉低信息量的关键帧和冗余的 OCR 结果。

- 构建预训练样本:将处理后的关键帧、ASR 文本和 OCR 文本按时间顺序交错组合,形成图像 - 文本交错的预训练样本,用于后续的视觉语言模型预训练。

具体应用场景

- 提升视觉语言模型性能:在多个知识和推理密集型任务的基准测试中,如 ScienceQA 和 MathVista,使用该多模态教科书预训练的模型相比使用其他数据集预训练的模型表现出显著的性能提升,尤其在需要知识理解和推理的任务中优势明显。

- 增强模型的上下文学习能力:在少样本学习设置下,预训练于该教科书数据集的模型在处理一般领域的视觉问答任务(如 OKVQA 和 TextVQA)时,随着样本数量增加,性能逐渐提升,表明模型能够更好地利用上下文信息进行学习和推理,这得益于数据集中连贯的视频帧与 ASR 文本交错设计,增强了模型的上下文感知能力。