文章目录[隐藏]

AI视频生成领域近期算是非常热闹,明星创业公司如 Runway 旗下 AI 视频生成工具 Gen2、「Morph Studio」 和「Moonvalley」, Stability AI也推出了AI 视频生成模型 Stable Video Diffusion,互联网大厂们也不甘示弱,阿里的研究团队才公布AI 动画生成框架 Animate Anyone 引发关注,新加坡国立大学和字节跳动就在昨天直接公布了新的AI 动画生成框架MagicAnimate,它的作用简单来说就是:一张图片 + 一组动作 = 视频。目前MagicAnimate已经上架GitHub开源并释出模型,今天小编就来教大家如何在本地安装MagicAnimate,快来看看吧!

[t-success icon='']MagicAnimate[/t-success]

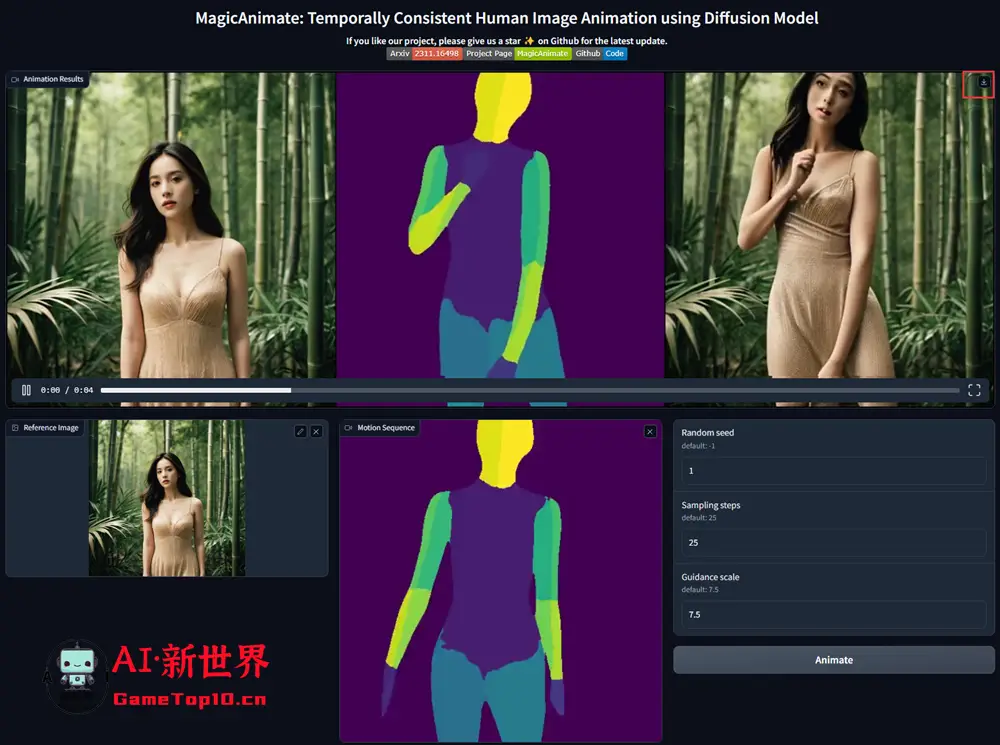

MagicAnimate是由新加坡国立大学 Show 实验室和字节跳动联合联合打造,它们提出了一个基于扩散的AI 动画生成框架,旨在增强时间一致性、忠实地保留参考图像并提升动画保真度。它能够将指定的人物图片与动作相结合,生成视频。MagicAnimate是基于StableDiffusion V1.5 基本模型,用户只需输入照片和动作,AI便会生成相应的视频,从目前生成的效果来说还比较粗糙,但随着技术发展,之后取代抖音小姐姐也并非空想。关于MagicAnimate具体技术细节可进入项目主页,查看该技术论文。

[t-success icon='']如何安装MagicAnimate?[/t-success]

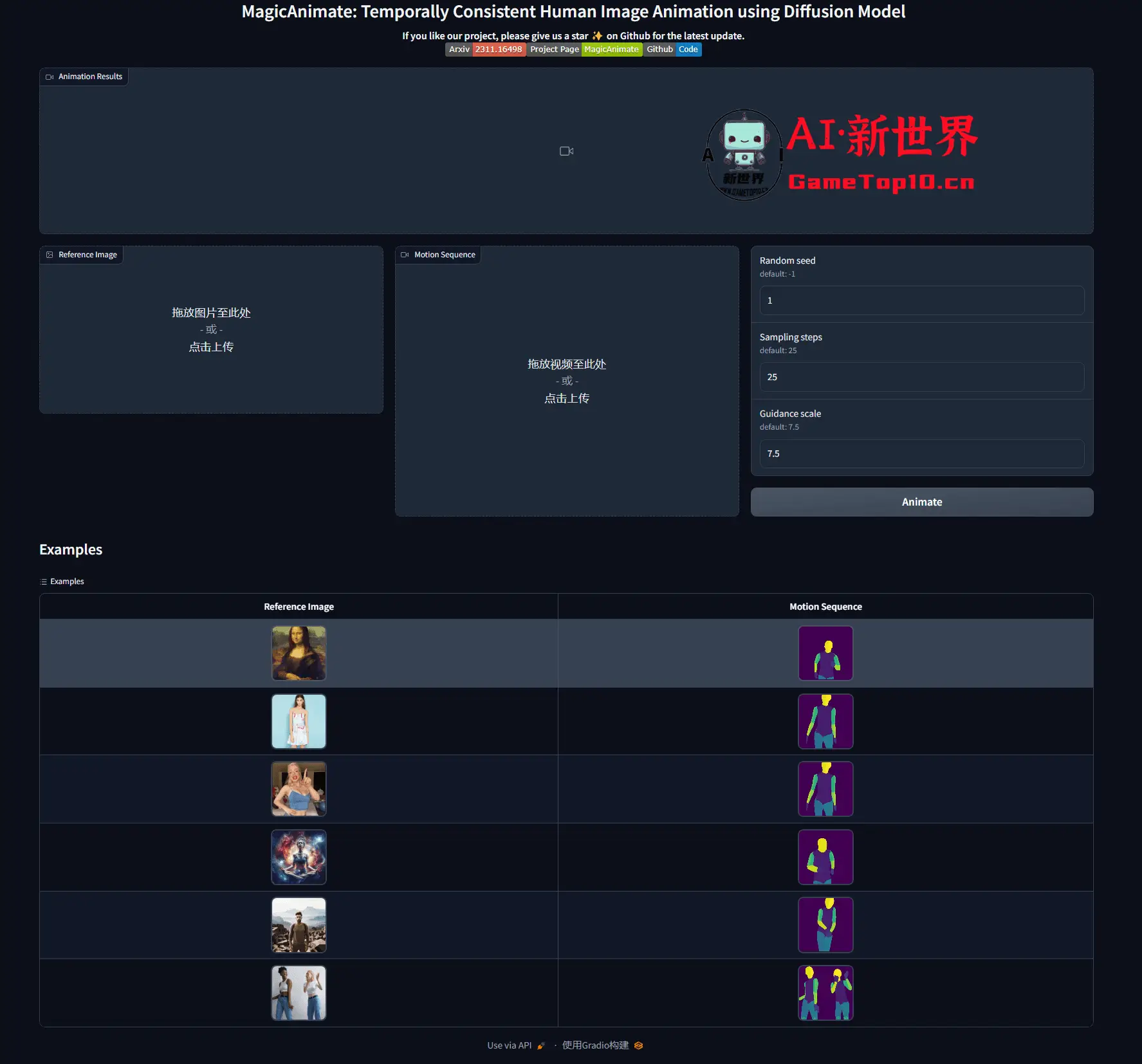

一、官方Demo

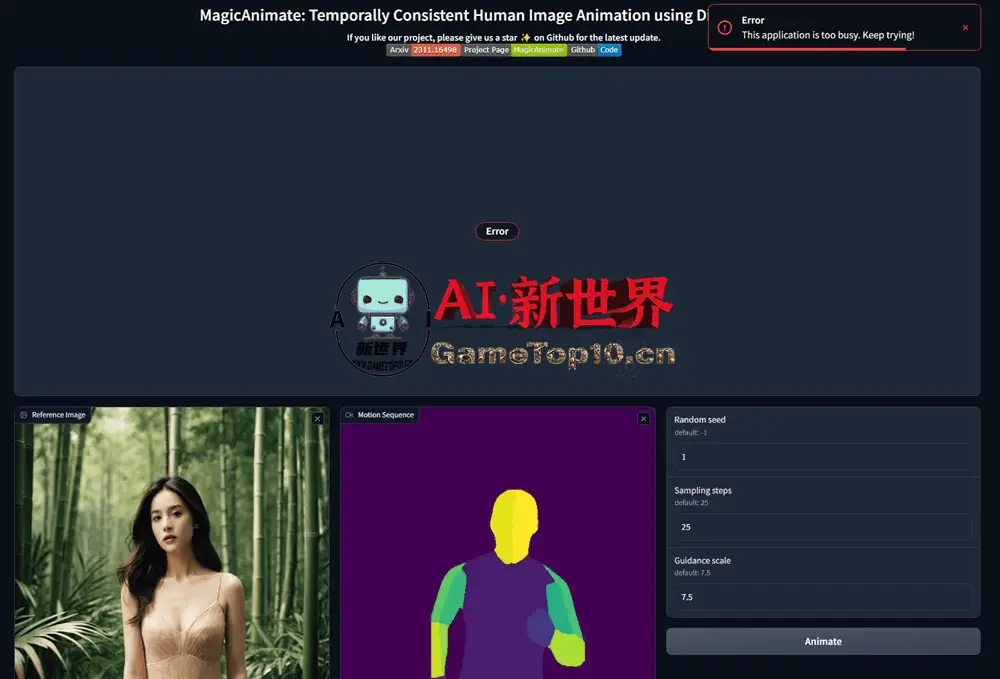

目前官方在Hugging Face上搭建了官方Demo,由试玩人数过多,目前该Demo基本无法运行。

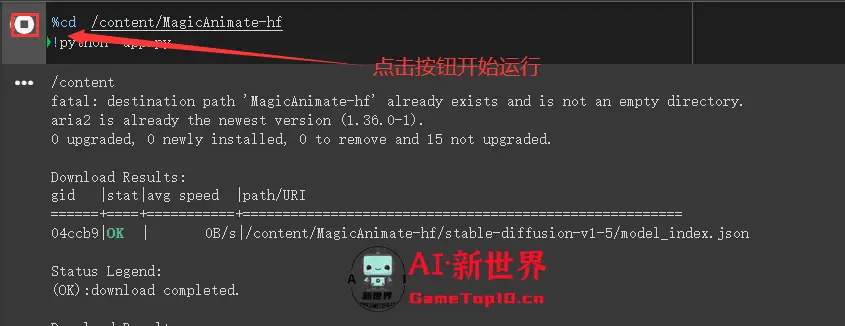

二、Google Colab

官方Demo无法运行,就有网友制作了Colab版本,可以一键运行MagicAnimate。

进入Colab后点击左上方的播放按钮,下载MagicAnimate项目与模型

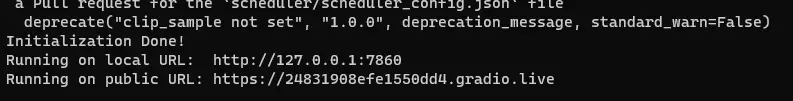

👇下载完毕后,在出现下面这两个链接后,点击public UR即可进入MagicAnimate页面

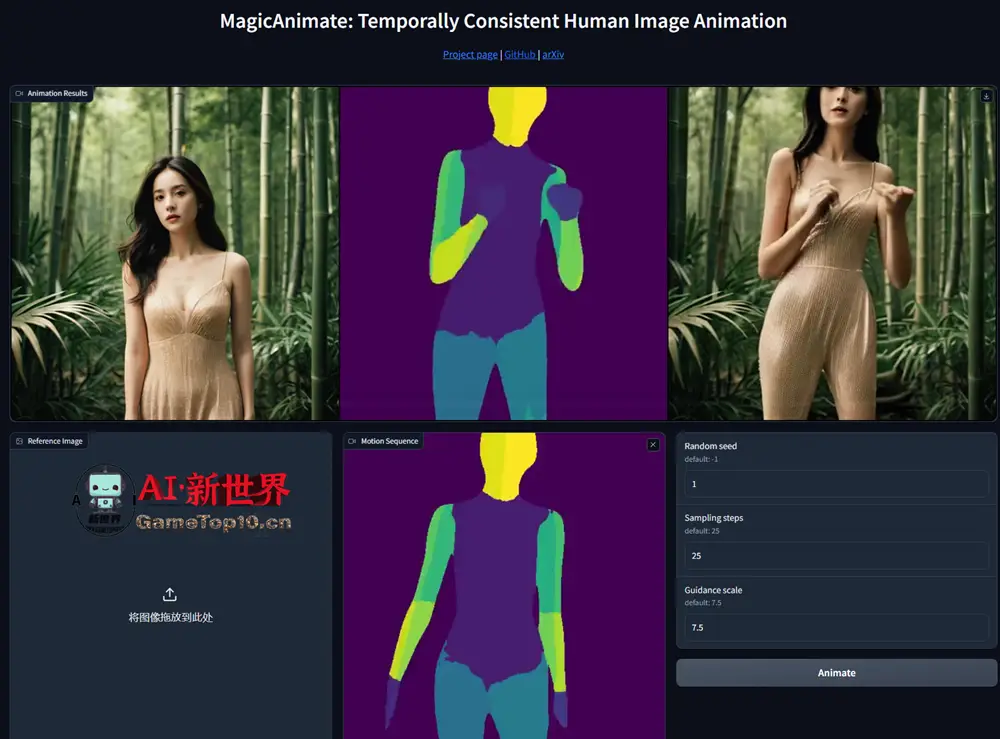

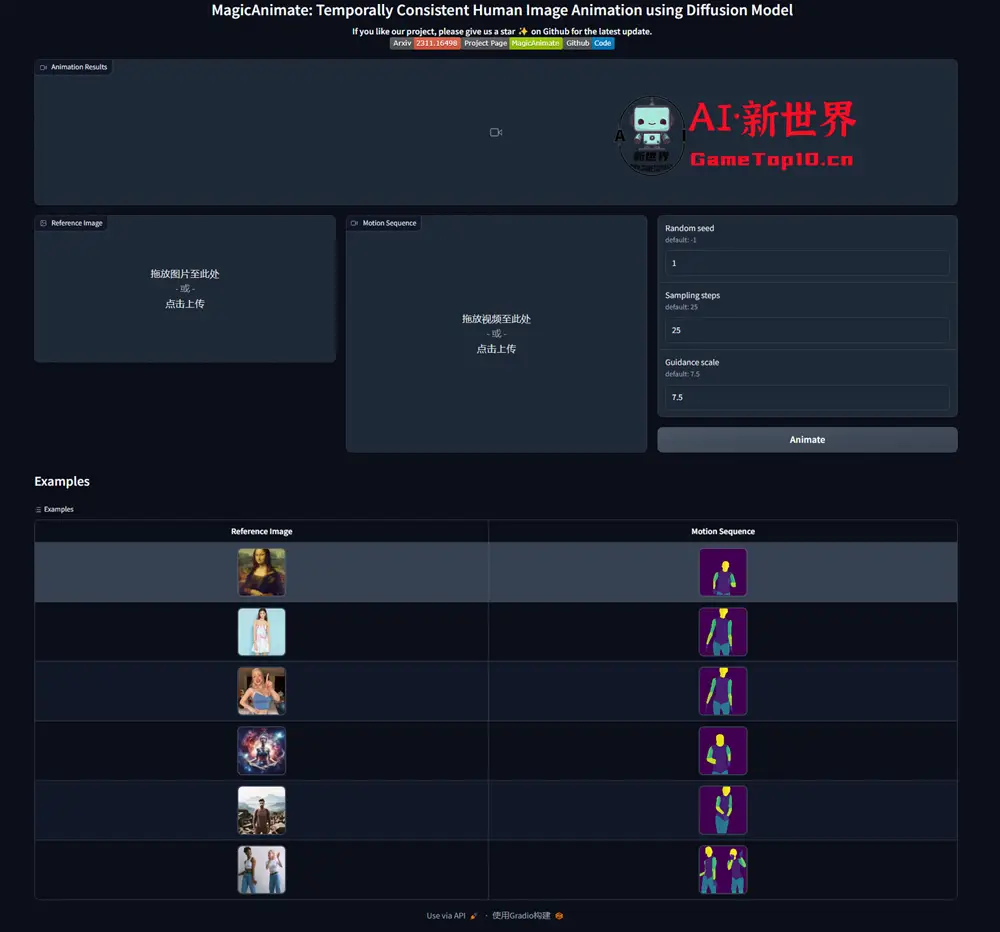

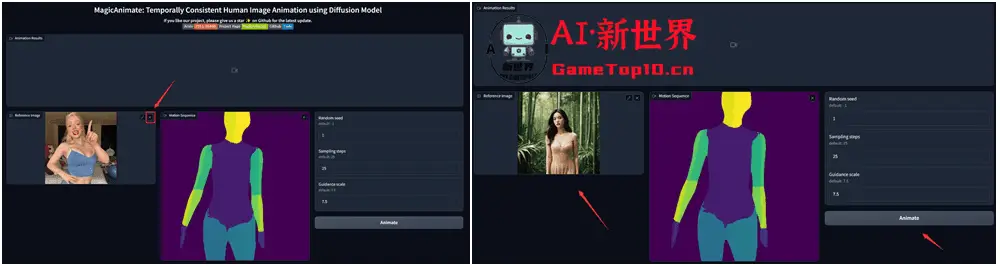

👇从下面的例子中挑选一个,然后替换图片,点击Animate即可开始生成视频。具体操作步骤将在下面的本地安装方法里进行讲解

三、本地安装

本人以Windows11系统安装为例,要安装MagicAnimate,还有前提条件:python>=3.8、CUDA>=11.3、ffmpeg 和 git,大家需要先安装这几个软件后才能进行下一步安装,而CUDA和ffmpeg会有环境变量的问题,可以参考《「FaceFusion」安装教程》里如何设置环境变量

- Python:https://www.python.org/downloads

- git: https://git-scm.com/download/win

- ffmpeg:https://ffmpeg.org

- CUDA:https://developer.nvidia.com/cuda-toolkit

如果网络环境允许,可使用以下命令行来安装Python、GIT和FFmpeg,请在命令提示符(CMD)或者终端进行下载及安装:

Python winget install -e --id Python.Python.3.10 GIT winget install -e --id Git.Git FFmpeg winget install -e --id Gyan.FFmpeg

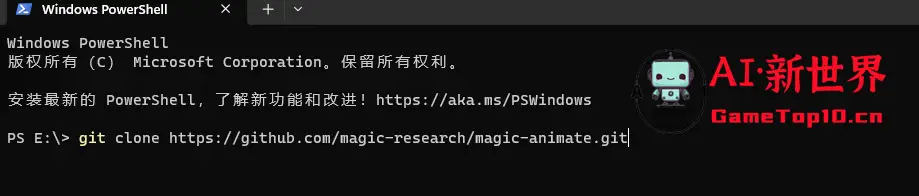

1、安装完以上软件后即可正式开始安装MagicAnimate,选择安装位置,需要注意的是安装路径不要有中文,使用以下代码下载此项目:

git clone https://github.com/magic-research/magic-animate.git

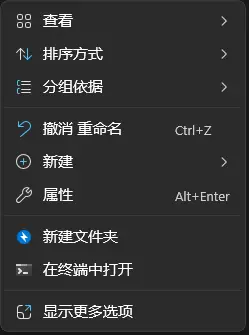

👇使用命令提示符(CMD)或者终端进行下载及安装,右键单击即可选择终端打开

2、下载完MagicAnimate后,需要为MagicAnimate安装及激活python环境,使用以下命令:

cd magic-animate python -m venv venv .\venv\Scripts\activate

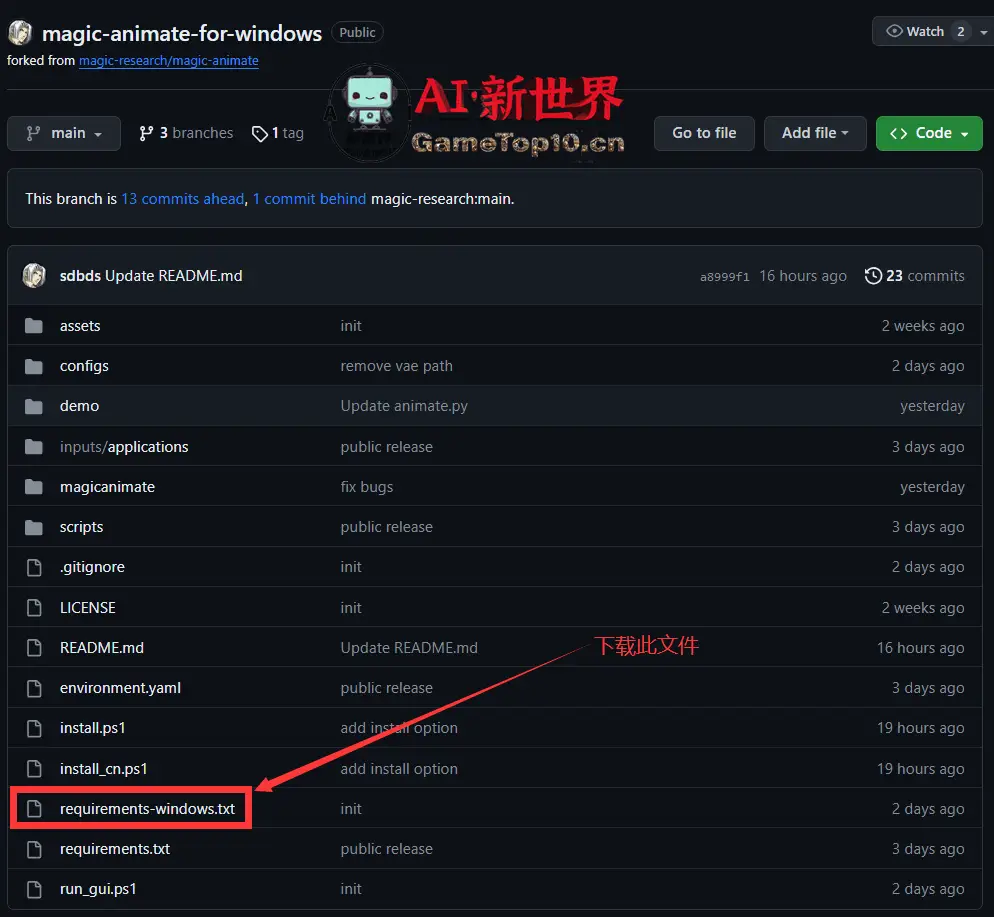

3、接下来就需要安装第三方依赖,但官方GitHub页面给出的安装方法是Linux系统的安装方法,按照官方的方法在Windows上安装会出错,解决方法就是使用B站大佬"青龙圣者"修改后的版本里的requirements-windows.txt文件

GitHub地址:https://github.com/sdbds/magic-animate-for-windows/tree/main

👇下载requirements-windows.txt文件后将此文件放到magic-animate文件夹内

4、使用以下代码安装第三方依赖,目前国内网络环境安装都是调用清华的源进行下载

pip install -r requirements-windows.txt

如果想更换源,可以直接在后面加-i ,如

pip install -r requirements-windows.txt -i https://mirror.baidu.com/pypi/simple

5、接下来就是下载模型,MagicAnimate需要 StableDiffusion V1.5 模型、MSE-finetuned VAE以及MagicAnimate模型

StableDiffusion V1.5下载地址:https://huggingface.co/runwayml/stable-diffusion-v1-5

VAE下载地址:https://huggingface.co/stabilityai/sd-vae-ft-mse

MagicAnimate地址:https://huggingface.co/zcxu-eric/MagicAnimate

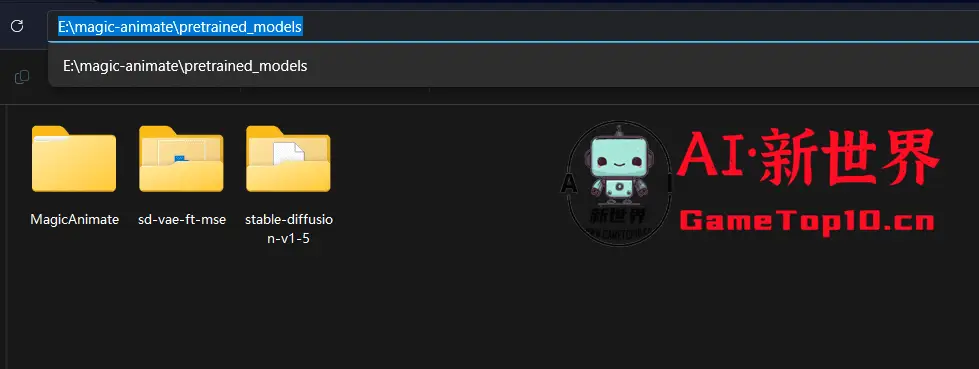

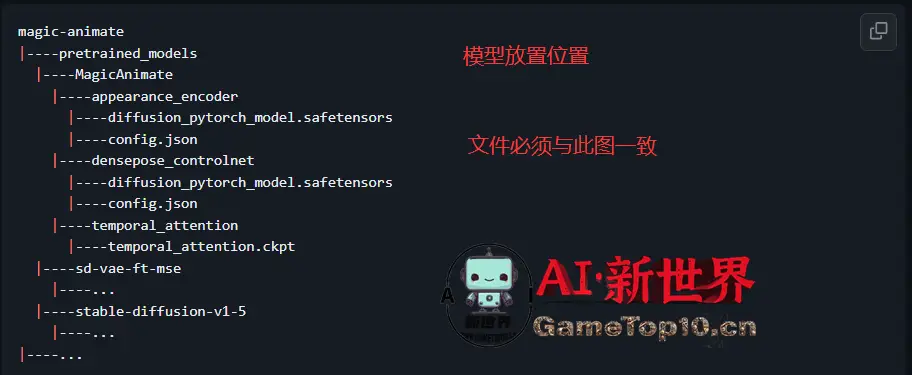

在magic-animate文件夹新建文件夹并命名为pretrained_models,在此文件夹下新建对应文件夹将模型以及VAE放入其内

👇下载后文件名需要与下图作对应,小编已经将模型下载后上传到国内网盘,大家可以从网盘下载

6、模型安装完毕后就可以启动MagicAnimate,如果你是单张英伟达显卡,使用以下命令来启动:

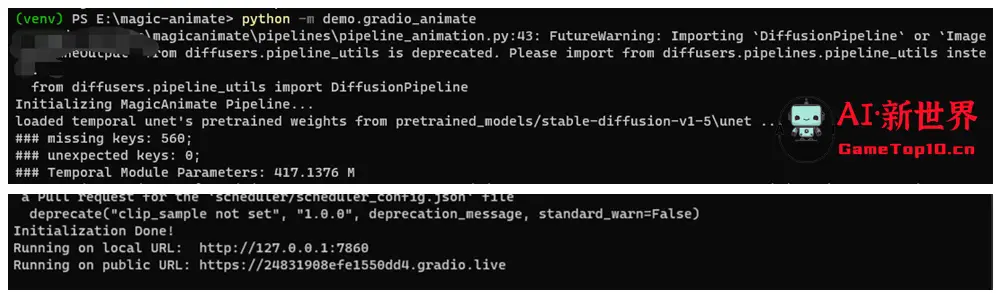

python -m demo.gradio_animate

多显卡:

python -m demo.gradio_animate_dist

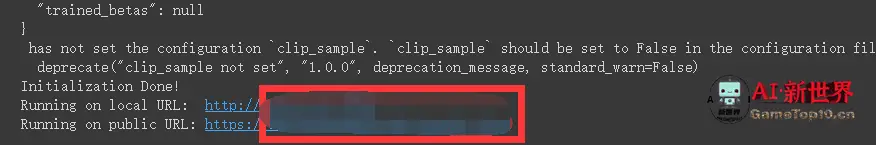

👇加载完模型后即出现下面两个网址,使用Ctrl+单击鼠标左键即可打开MagicAnimate

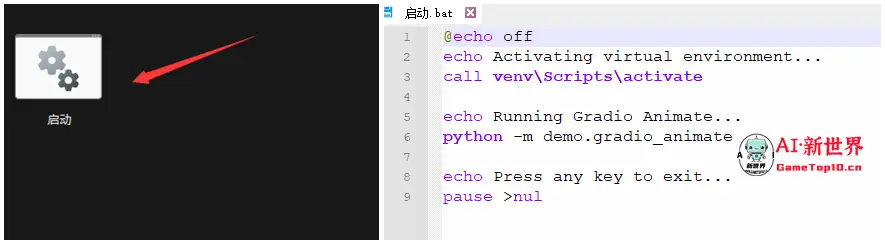

7、在magic-animate文件夹下新建一个文本文档,输入以下命令行,然后将文件名从.txt 改为.bat,之后点击该.bat 文件即可快速启动应用

@echo off echo 正在激活虚拟环境... call venv\Scripts\activate echo 正在运行 Gradio Animate... python -m demo.gradio_animate echo 按任意键退出... pause >nul

[t-success icon='']如何使用MagicAnimate?[/t-success]

上传图片+运动视频,点击Animate 即可开始生成视频,不过运动视频需要处理与官方范例相同才可以进行生成,这就是需要你使用视频编辑软件利用蒙版等方法进行处理,还需要对身体各部位进行标色处理,最简单的做法自然就是套用官方的范例来进行生成了

1、选择一个范例,在图片处图片右上方点击x,删除该图片后上传一张新的图片,由于使用SD1.5模型以及官方范例的照片和Motion Sequence(运动序列)都是1:1比例的大小,也就是512X512,所以替换图最好也是1:1比例,不然生成的视频会有崩坏的情况出现

2、首次生成视频,速度会很慢,比如小编的英伟达RTX4070显卡首次生成视频耗时6分多钟,第二次就会快不少

👇对于显存的占用非常高,如果你的显卡不好,那么就不要安装此应用了,因此建议大家《AI革命来临!什么样的电脑配置才适应时代?AI大模型运行所需电脑配置大揭秘》

3、生成的视频可下载,也可以在此目录下magic-animate\demo\outputs找到,通过视频编辑软件做进一步处理即可使用,不过目前生成的视频并不完美,希望之后能够支持SDXL模型或者其他SD模型

[t-success icon='']结语[/t-success]

从目前生成的视频效果来看,目前远不如一些自媒体吹嘘的抖音小姐姐失业什么的程度,期待官方后续继续改进以及大神们开发出更多的玩法,本人已将此项目下载上传到国内网盘,如果自己安装不好,可以进去网盘进行下载:

123网盘:https://www.123pan.com/s/I1oZVv-9EUGA.html 提取码:AudV

百度网盘:https://pan.baidu.com/s/1TEY4_38XPSJegHkDfCptgQ?pwd=r84x