多模态大语言模型(MLLMs)在理解和分析视频内容方面取得了显著进展。然而,由于LLM的上下文大小限制,处理长视频仍然是一个重大挑战。传统的视频处理方法通常需要大量的计算资源,并且难以在保持视觉细节的同时减少视频标记的数量。为了解决这一问题,Meta AI、阿卜杜拉国王科技大学和高丽大学的研究人员提出了LongVU,一个时空自适应压缩机制,能够在保留长视频视觉细节的同时减少视频标记的数量。

- 项目主页:https://vision-cair.github.io/LongVU

- GitHub:https://github.com/Vision-CAIR/LongVU

- 模型:https://huggingface.co/collections/Vision-CAIR/longvu-67181d2debabfc1eb050c21d

- Demo:https://huggingface.co/spaces/Vision-CAIR/LongVU

LongVU是一个针对长视频语言理解任务的多模态大语言模型(MLLM)。LongVU的核心目标是在保持视觉细节的同时,减少长视频处理中的计算负担,特别是在有限的上下文长度内处理长视频数据。这对于理解和分析长视频内容具有重要意义,因为长视频通常包含大量的冗余信息。

例如,考虑一个长视频,其中包含了一系列的动作和事件。传统的视频处理方法可能会均匀地从视频中采样固定数量的帧,但这样可能会忽略视频中的关键帧,或者由于上下文长度限制而无法处理整个视频。LongVU通过时空自适应压缩机制,可以有效地减少视频中的冗余帧,同时保留与文本查询最相关的帧的详细信息,从而在有限的上下文长度内处理整个长视频。

主要功能和特点

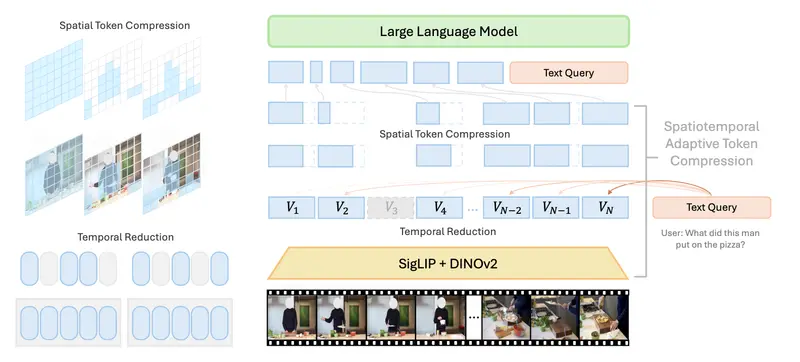

- 时空自适应压缩:LongVU通过利用跨模态查询和帧间相似性来减少视频令牌的数量,而不损失太多视觉细节。

- 保持视觉细节:通过选择性地保留与文本查询最相关的帧的详细信息,LongVU能够在减少计算负担的同时,保持视频内容的关键视觉信息。

- 提高长视频理解能力:LongVU在多个视频理解基准测试中表现出色,特别是在理解长达一小时的视频任务上。

工作原理

- 帧特征提取和时间压缩:使用DINOv2特征提取器来识别并去除视频中高度相似的冗余帧。

- 跨模态查询选择性特征减少:基于文本查询,选择性地保留关键帧的完整令牌,同时对其余帧应用空间池化以减少令牌数量。

- 空间令牌压缩:基于帧间的时间依赖性,进一步压缩视频帧的空间令牌,以适应大型语言模型的上下文长度限制。

具体应用场景

- 视频内容分析:LongVU可以用于分析长视频中的内容,提取关键信息,例如在监控视频中识别特定事件或行为。

- 视频问答:LongVU能够理解长视频内容并回答与视频内容相关的问题,适用于教育、娱乐和信息检索等领域。

- 视频摘要和描述:LongVU可以生成长视频的摘要或详细描述,有助于快速了解视频主要内容,适用于内容创作和社交媒体平台。

- 视频搜索和检索:LongVU可以通过理解视频内容来改进视频搜索和检索系统,帮助用户找到他们感兴趣的特定片段。

总的来说,LongVU通过其创新的时空自适应压缩机制,为长视频语言理解任务提供了一个有效的解决方案,能够在保持视频内容关键信息的同时,显著提高处理效率。