随着大语言模型(LLMs)如ChatGPT的普及,AI在处理高度敏感信息的领域(如医疗保健、教育和个人发展)中的角色日益突出。这些模型通常能够处理大数据集并提供令人印象深刻的结果,但也引发了重大的隐私问题。用户交互可能在模型响应中无意中泄露个人身份信息(PII),这使得在不牺牲模型性能的情况下保护敏感信息成为一个亟待解决的问题。

当前挑战

- 隐私泄露:

- 专有LLM通常由于广泛的数据和训练而提供最佳结果,但可能通过无意的PII泄露暴露敏感信息。

- 开源模型在本地托管,通过限制外部访问提供了一个更安全的替代方案,但它们通常需要比专有模型更多的复杂性和质量。

- 隐私与性能的权衡:

- 传统方法通过在训练前对数据进行净化来保护隐私,但这不能防止实时使用中的隐私泄露。

- 用户数据保护措施包括在将输入发送到外部服务器之前对其进行匿名化处理,但这通常以响应质量为代价,因为模型失去了可能对准确响应至关重要的上下文。

PAPILLON:隐私保护的新方法

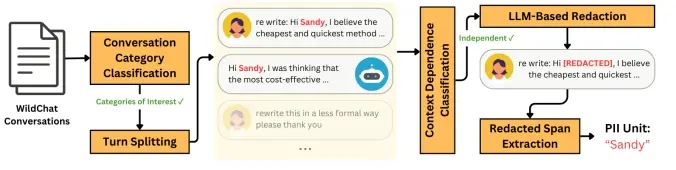

哥伦比亚大学、斯坦福大学和Databricks的研究人员提出了一种名为PAPILLON(PrivAcy Preservation from Internet-based and Local Language MOdel ENsembles)的新型隐私保护管道。PAPILLON旨在整合本地开源模型和高性能专有模型的优势,通过“隐私意识委托”概念保护用户隐私。

核心机制

- 隐私意识委托:

- 本地模型:本地模型因其隐私性而受信任,充当用户和专有模型之间的中介。

- 过滤敏感信息:在向外部模型发送任何请求之前,本地模型过滤掉敏感信息,确保私人数据保持安全。

- 提示优化技术:

- 选择性修订:使用本地模型处理用户查询,选择性地修订或掩盖敏感信息。

- 定制提示:如果查询需要更复杂的处理,启用专有模型,但通过定制提示指导专有模型同时隐藏个人数据。

系统设计

- 多阶段管道:

- 初始处理:使用本地模型处理用户查询,选择性地修订或掩盖敏感信息。

- 复杂处理:如果需要更复杂的处理,启用专有模型,但仅在最小暴露于PII的情况下。

- 模块化结构:

- 适应性:PAPILLON的设计是模块化的,可以根据任务的隐私和质量需求适应各种本地和专有模型的组合。

实验结果

研究人员使用Private User Prompt Annotations(PUPA)基准数据集测试了PAPILLON的有效性,该数据集包含901个包含PII的真实用户查询。实验结果表明:

- 响应质量:在最佳配置中,PAPILLON实现了85.5%的响应质量率。

- 隐私保护:将隐私泄露控制在7.5%,表明在性能和安全性之间实现了有效的平衡。

- 模型组合:成功测试了Llama-3.18B-Instruct和GPT-4o-mini等不同模型组合,展示了系统的灵活性和适应性。

关键优势

- 高质量与低隐私泄露:

- PAPILLON实现了85.5%的响应质量率,同时将隐私泄露限制在7.5%,表明在性能和安全性之间实现了有效的平衡。

- 灵活的模型使用:

- PAPILLON的设计使其能够有效地使用开源和专有模型,成功测试了Llama-3.1-8B和GPT-4o-mini等配置。

- 适应性:

- 管道的模块化结构使其适应各种LLM组合,扩大了其在需要隐私保护的多样化任务中的适用性。

- 提高隐私标准:

- 与简单的修订方法不同,PAPILLON保留了上下文以保持响应质量,证明比传统的匿名化方法更有效。

未来潜力

PAPILLON为在AI中集成隐私意识技术提供了有希望的前进道路。通过缩小隐私与质量之间的差距,PAPILLON使得敏感应用可以在不冒用户数据风险的情况下利用AI。这种方法表明,隐私意识委托和提示优化可以满足对安全、高质量AI模型的日益增长的需求。

总之,PAPILLON不仅在技术上实现了高性能和高隐私保护的平衡,还为未来隐私意识AI模型的进一步改进提供了框架,强调了在安全、适应性强的LLM技术方面持续进步的需求。