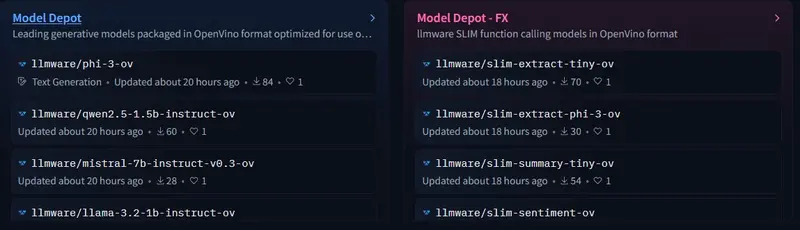

LLMWare.ai是一家在部署和微调小型语言模型(SLMs)方面的先驱,今天宣布在Hugging Face上推出Model Depot。Model Depot是为英特尔PC优化的SLMs的最大集合之一,涵盖了超过100个模型,适用于聊天、编码、数学、函数调用和嵌入模型等多种用例。这一举措旨在为开源AI社区提供前所未有的最新SLMs集合,这些模型针对英特尔PC上的Intel OpenVINO和ONNX格式进行了优化。

- 官网:https://llmware.ai

- 项目主页:https://llmware-ai.github.io/llmware

- GitHub:https://github.com/llmware-ai/llmware

- 模型:https://huggingface.co/llmware

Model Depot的主要特点

- 广泛的模型覆盖:

- 超过100个模型:涵盖聊天、编码、数学、函数调用和嵌入模型等多种用例。

- 优化格式:模型针对Intel OpenVINO和ONNX格式进行了优化,适用于英特尔硬件。

- 高性能优化:

- 4位量化:LLMWare的白皮书显示,4位量化的小型语言模型(1B-9B参数)在英特尔AI PC上最大化模型推理性能。

- 测试结果:在配备英特尔酷睿Ultra 9(Meteor Lake)的戴尔笔记本电脑上,使用1.1B参数的BLING-Tiny-Llama模型,OpenVINO量化格式导致推理速度比PyTorch快7.6倍,比GGUF快7.5倍。

- 强大的工具支持:

- LLMWare开源库:提供了一个完整的工具包,用于AI驱动工作流的端到端开发。

- RAG和基于代理的工作流:支持使用OpenVINO格式的SLMs为英特尔硬件用户创建检索增强生成(RAG)和基于代理的工作流。

- 多格式支持:

- OpenVINO:开源库,用于优化和部署深度学习模型推理能力,支持在CPU、GPU和英特尔NPU上进行模型推理。

- ONNX:开源格式,提供AI模型的互操作性,支持多种框架和硬件。

Model Depot的优势

- 提高性能:

- 优化推理:通过OpenVINO和ONNX格式的优化,模型在英特尔硬件上的推理速度显著提升。

- 多步工作流:支持多步骤工作流和RAG,提高模型在复杂任务中的性能。

- 易用性和灵活性:

- 多格式支持:支持OpenVINO、ONNX和Llama.cpp,开发者可以选择最适合其目标硬件的模型格式。

- 端到端工具包:LLMWare的开源库提供了从模型加载到部署的完整工具链。

- 安全性和成本节约:

- 本地部署:AI应用可以在设备上部署,避免敏感数据的外部传输,增加安全性。

- 成本节约:本地部署减少了对外部系统的依赖,降低了成本。

Model HQ:与英特尔的战略合作

LLMWare还宣布了与英特尔的战略合作,推出了Model HQ的有限发布,供私人预览。Model HQ专门为配备英特尔酷睿Ultra处理器的AI PC设计,提供了一个开箱即用的无代码工具包,用于运行、创建和部署AI驱动的应用。

- 开箱即用的功能:

- 聊天机器人:内置聊天机器人功能,支持自然语言处理和对话生成。

- 文档搜索与分析:强大的文档搜索和分析功能,支持复杂的信息检索任务。

- 企业级安全:

- 模型保险库:用于模型安全检查。

- 模型安全监控:用于毒性和偏见筛查。

- 幻觉检测器:检测和防止模型生成虚假信息。

- AI可解释性数据:提供模型决策的透明度。

- 合规性和审计工具包:确保模型符合法规要求。

- 隐私过滤器:保护用户隐私。

LLMWare通过推出Model Depot和Model HQ,为英特尔PC用户提供了强大的工具和优化的模型,以实现高性能、安全和成本效益的AI应用部署。这些举措不仅提高了模型的推理速度和性能,还为开发者提供了灵活的工具和支持,使其能够轻松构建和部署AI应用。LLMWare和英特尔的合作展示了双方在推动AI技术发展和普及方面的共同承诺。