广西大学商学院和西南财经大学计算机与人工智能学院的研究人员推出旋律引导音乐生成模型MG²,这是一种新颖的音乐生成方法,它利用旋律来指导音乐的生成。MG²模型以其简单方法和有限资源实现了出色的性能。

- 项目主页:https://awesome-mmgen.github.io

- GitHub:https://github.com/shaopengw/Awesome-Music-Generation

- 模型:https://huggingface.co/ManzhenWei/MG2

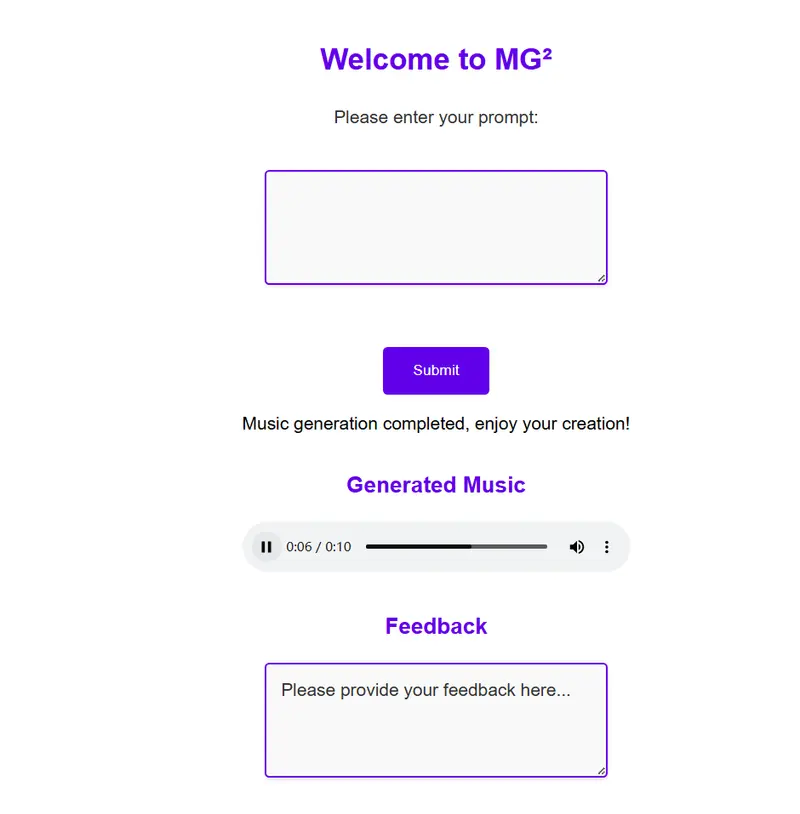

- Demo:https://mg2.vip.cpolar.cn

例如,我们有一段描述性的文本,比如“宁静的夏夜,微风轻拂”,MG²模型可以根据这个文本描述生成一段旋律和音乐波形,这段音乐不仅在语义上与文本相匹配,而且在风格上也反映出文本内容的宁静和轻松。

主要功能:

- 旋律引导的音乐生成:MMGen使用旋律来引导音乐的生成,确保生成的音乐在整体和每个片段中都保持和谐。

- 多模态对齐:模型通过多模态对齐模块将旋律、音频波形和文本描述对齐到同一语义空间。

- 数据集构建:为了解决高质量数据稀缺的问题,研究者构建了一个包含旋律、文本和音频的多模态数据集MusicSet,并计划公开提供。

主要特点:

- 旋律利用:首次尝试利用旋律生成音乐波形,增强音乐的和谐性和音乐性。

- 多模态数据集:构建了一个新的多模态音乐数据集MusicSet,包含超过100,000个样本,每个样本都与旋律、音频波形和文本描述相关联。

- 检索增强生成:通过检索增强方法,模型能够从外部数据库中检索相关信息,以提高生成性能。

工作原理:

MG²模型包括三个核心组件:

- 多模态对齐模块:将音乐波形、旋律和文本描述对齐到同一向量空间。

- 生成模块:基于对齐后的表示,生成音乐潜在向量。首先构建旋律向量数据库,然后检索相关旋律作为生成过程的指导。

- 解码器:将生成的音乐潜在向量处理成可播放的音乐波形,包括变分自编码器(VAE)和声码器。

具体应用场景:

- 个性化背景音乐生成:为短视频平台(如TikTok、YouTube Shorts)生成个性化背景音乐。

- 舞蹈、虚拟现实和游戏音乐:在舞蹈编排、虚拟现实体验和电子游戏中提供适配的音乐。

- 音乐创作辅助:辅助音乐家和音乐爱好者创作新的旋律和音乐作品。

总的来说,MMGen模型通过旋律引导的音乐生成方法,提供了一种新的音乐创作和生成方式,能够在多种应用场景中实现高质量的音乐生成。