海人工智能实验室、上海交通大学、香港大学和麻省理工学院的研究人员推出一个名为OS-ATLAS的模型,这是一个为通用图形用户界面(GUI)代理设计的基础动作模型。OS-ATLAS旨在通过创新的数据和建模方法,在GUI定位和跨分布(Out-Of-Distribution,OOD)场景中表现出色,以提高个性化GUI代理的效率和鲁棒性。

- 项目主页:https://osatlas.github.io

- GitHub:https://github.com/OS-Copilot/OS-Atlas

- 模型:https://huggingface.co/collections/OS-Copilot/os-atlas-67246e44003a1dfcc5d0d045

例如,你想要自动化一个任务,比如在Visual Studio Code中修改设置以隐藏所有的__pycache__文件夹。OS-ATLAS可以分析屏幕截图和你给出的自然语言指令(如“隐藏所有__pycache__文件夹”),然后生成一系列可执行的动作,比如点击设置图标、在搜索设置输入框中输入“files: exclude”等,以完成这个任务。

主要功能:

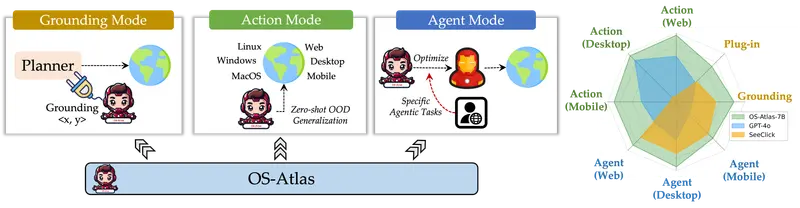

- GUI定位(Grounding):将自然语言指令转换为可以在操作系统中执行的动作。

- 动作执行:在GUI环境中执行如点击、滚动、输入等动作。

- 跨平台兼容性:支持多种操作系统和平台,包括Windows、Linux、MacOS、Android和Web。

主要特点:

- 数据合成工具包:开发了一个开源工具包,可以自动合成多个平台的GUI定位数据。

- 大规模数据集:发布了迄今为止最大的开源跨平台GUI定位语料库,包含超过1300万个GUI元素。

- 模型训练创新:通过模型训练的创新,OS-ATLAS能够理解GUI截图并泛化到未见过的界面。

- 快速适应:适应新身份的过程可以在15分钟内完成,比以前的方法快47倍。

工作原理:

OS-ATLAS的工作原理包括以下几个步骤:

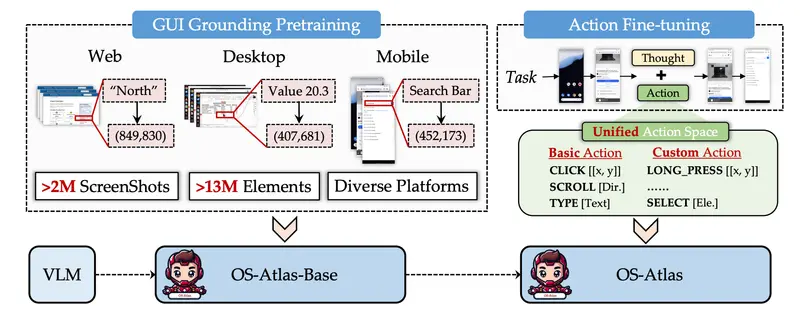

- GUI定位预训练:使用大量的<截图,元素引用表达或指令,元素坐标>三元组数据训练模型,使模型能够理解GUI截图并识别屏幕上的元素。

- 动作微调:在GUI定位预训练的基础上,使用<截图,任务指令,动作历史>三元组数据进一步训练模型,使其能够预测相应的动作。

- 统一动作空间:为了解决不同数据源之间的动作空间冲突问题,提出了一个统一动作空间,包括基本动作和自定义动作,以标准化所有现有数据集的格式。

具体应用场景:

- 自动化日常任务:比如自动化配置软件设置、自动化填写表单等。

- 虚拟助手:在桌面环境或移动应用中,根据用户的语音或文本指令执行特定任务。

- 测试和质量保证:自动化测试GUI应用,确保应用的稳定性和可用性。

- 跨平台应用开发:在不同的操作系统和设备上开发和测试GUI应用。

总的来说,OS-ATLAS通过结合大规模数据集和模型训练的创新,提供了一个强大的工具,可以在多种应用场景中实现高质量的GUI自动化任务。