共计 627 个字符,预计需要花费 2 分钟才能阅读完成。

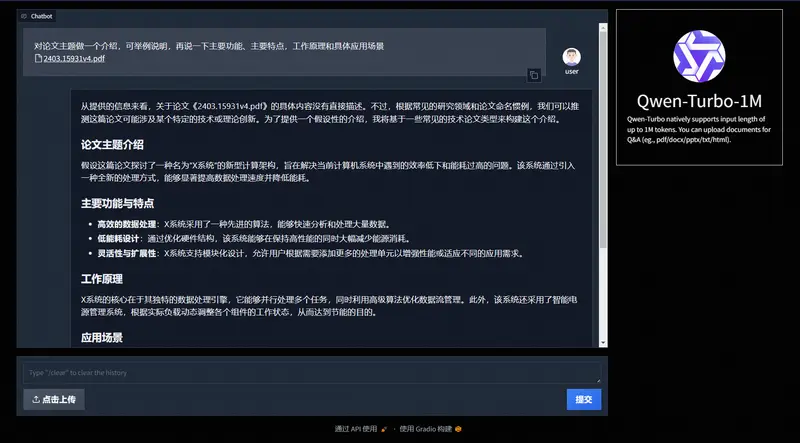

阿里通义团队发布了 Qwen2.5-Turbo 模型,将上下文长度从 128k 扩展到了 1M,相当于 100 万个英文单词或 150 万个汉字,这大约是 10 本长篇小说、150 小时的演讲稿或 3 万行代码的容量。该模型并不是开源模型,大家需要通过 API 接入。

Demo:https://www.modelscope.cn/studios/Qwen/Qwen2.5-Turbo-1M-Demo

官方介绍:https://qwenlm.github.io/zh/blog/qwen2.5-turbo

Qwen2.5-Turbo 版本,其特点在于:

- 更长的上下文支持: 我们首次将模型的上下文长度从 128k 扩展到 1M,该长度约为 100 万个英文单词或 150 万个汉字,相当于 10 本长篇小说,150 小时的演讲稿,3 万行代码。该模型能在 1M 长度的大海捞针 (Passkey Retrieval) 任务中实现 100% 的准确率,在长文本评测集 RULER 上获得 93.1 分,超越 GPT-4 的 91.6 分,GLM4-9B-1M 的 89.9 分。此外,在短序列能力上,该模型仍然保持了非常强的竞争力,与 GPT-4o-mini 持平。

- 更快的推理速度 : 利用稀疏注意力机制,我们成功将处理 1M tokens 上下文时的首字返回时间从 4.9 分钟降低到 68 秒, 实现 4.3 倍加速比。

- 更低的价格:价格仍为 0.3 元 / 1M tokens。在相同成本下,Qwen2.5-Turbo 相比 GPT-4o-mini 能够处理 3.6 倍的 Token。

正文完

关注公众号获取最新教程

发表至: 国产AI

2024-11-19