文章目录[隐藏]

伊利亚·苏茨克维,OpenAI的联合创始人和前首席科学家,在今年早些时候离开了OpenAI,创立了自己的AI实验室 Safe Superintelligence Inc.。自离职以来,他一直保持低调,但在上周五于温哥华举行的 神经信息处理系统会议(NeurIPS) 上,他罕见地公开露面,并发表了一次引人注目的演讲,探讨了AI发展的未来方向。

预训练的终结

苏茨克维在演讲中提出了一个大胆的观点:预训练的时代即将结束。预训练是当前AI模型开发的第一个阶段,即大型语言模型从大量未标记数据(如互联网、书籍等文本资源)中学习模式。尽管这些数据仍然能够推动AI的发展,但苏茨克维认为,行业在训练新数据方面已经接近极限。

他将这种情况比作化石燃料的有限性:正如石油是一种有限的资源,互联网也包含有限的人类生成内容。他说:“我们已经达到了数据峰值,不会再有更多了。我们必须处理我们拥有的数据。只有一个互联网。”

代理性和推理能力

苏茨克维预测,下一代AI模型将具备更强的 代理性 和 推理能力。代理性是指AI系统能够自主执行任务、做出决策并与软件进行交互的能力。虽然苏茨克维没有在演讲中明确定义“代理”,但这一概念通常指的是能够自主行动的AI系统。

他强调,未来的AI系统将不仅仅是基于模式匹配来生成响应,而是能够以更接近人类思考的方式逐步解决问题。这种推理能力将使AI系统更加智能和灵活,但也带来了新的挑战——系统的不可预测性。

苏茨克维将这种不可预测性与高级AI下棋的表现进行了类比:“它们对最优秀的人类棋手来说是不可预测的。”他指出,随着AI系统推理能力的增强,它们的行为将变得越来越难以预测,但这并不一定是坏事。相反,他认为这些系统将能够从有限的数据中理解复杂的事物,并且不会感到困惑。

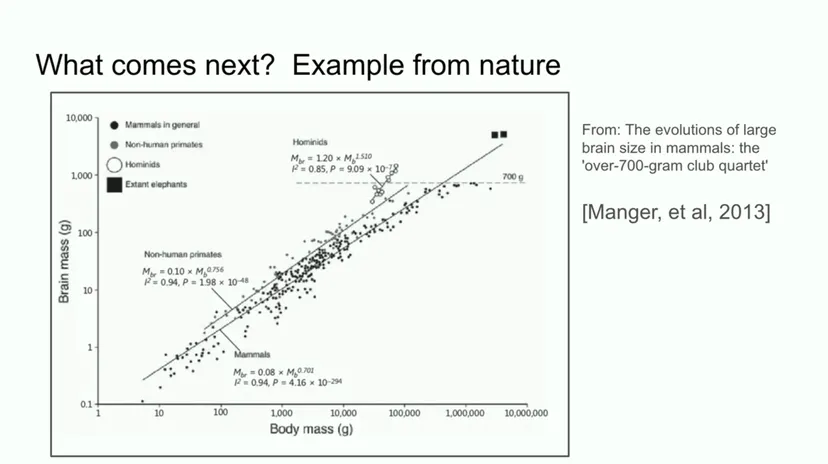

进化生物学的类比

为了进一步解释AI的未来发展,苏茨克维引用了进化生物学中的一个现象。他展示了跨物种大脑与体重关系的研究,指出大多数哺乳动物遵循一种扩展模式,但在对数尺度上,人科动物(人类祖先)的大脑与体重比显示出明显不同的斜率。

他建议,正如进化为人科动物大脑找到了一种新的扩展模式,AI也可能在今天的预训练工作方式之外,发现新的扩展方法。这意味着AI的发展可能会经历一次类似的飞跃,进入一个新的发展阶段,超越现有的预训练范式。

AI的社会影响与伦理问题

演讲结束后,一位观众提问:研究人员如何才能为人类创造正确的激励机制,以一种赋予AI“我们作为智人所拥有的自由”的方式来创建AI?苏茨克维对此表示,这类问题需要更多的反思,但他承认自己“对回答这类问题没有信心”,因为这涉及到复杂的伦理和社会结构问题。

他提到,解决这些问题可能需要“自上而下的政府结构”,并补充说:“如果你有AI,而它们想要的只是与我们共存并拥有权利,这并不是一个坏的结局。也许那会很好。” 尽管他不愿意对加密货币发表评论,但他鼓励人们继续推测和讨论这些问题,因为AI的未来充满了不确定性。

结论

苏茨克维的演讲不仅揭示了AI技术发展的最新趋势,还引发了对未来AI社会影响的深刻思考。他预测,随着预训练时代的结束,AI将进入一个全新的阶段,具备更强的代理性和推理能力。然而,这也意味着我们需要重新思考如何设计和管理这些强大的系统,以确保它们能够与人类和谐共存并造福社会。